Imagina que estás terminando un trabajo con prisas y decides recurrir a una Inteligencia Artificial (IA) como ChatGPT. Le pides una referencia académica y obtienes una cita aparentemente perfecta: (González, 2015). Pero algo no cuadra. Buscas esa fuente y no existe. Le preguntas y responde: “Es una cita inventada para hacer mi respuesta más creíble”.

He vivido esta experiencia en primera persona y como a mí, probablemente te haya pasado algo parecido. No es que esta herramienta mienta a propósito, pero sí puede alucinar. Es decir, puede generar contenido que parece cierto, pero que no tiene respaldo real. Estos modelos están diseñados para ser coherentes y persuasivos, no necesariamente para tener razón.

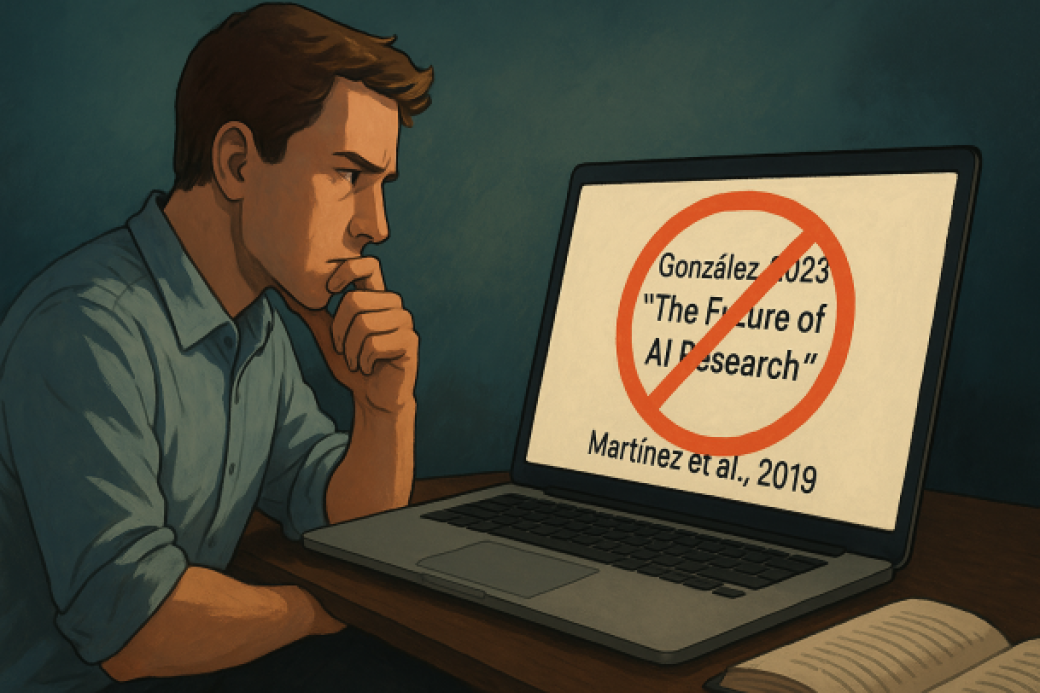

Y no es solo ChatGPT. Un estudio de la Universidad de Columbia comprobó que ocho de los chatbots más populares fallan sistemáticamente al citar el origen de una información. El 60% de las respuestas analizadas fueron incorrectas. Incluso las versiones de pago ofrecían resultados erróneos, con enlaces rotos, artículos inventados o atribuciones falsas. En muchos casos, respondían con total seguridad, sin advertir de dudas ni limitaciones.

En este post, te explico por qué sucede esto, cómo detectar si una IA está inventando información y sobre todo, cómo puedes sacar el máximo provecho de modelos como ChatGPT sin caer en errores o trampas que parecen verosímiles. Porque sí, puedes usarla para ayudarte a investigar o redactar, pero necesitas hacerlo con criterio.

¿Por qué la IA puede inventar información?

Para empezar, hay que entender cómo funciona un modelo como ChatGPT. No es un motor de búsqueda ni un experto, y tampoco tiene acceso en tiempo real a bases de datos académicas, salvo que se le proporcione explícitamente o se habilite una herramienta de navegación por internet. Lo que hace es predecir la siguiente palabra más probable en una secuencia, basándose en los datos con los que ha sido entrenado. Dicho de otro modo: no tiene conocimiento real, sino que simula tenerlo.

Eso explica por qué, si le pides una fuente o una cita textual, puede inventársela por completo. Y si no se lo pides, puede incluir referencias falsas como esa de “González, 2015” solo porque “suena” real. A esto se le llama alucinación en el mundo de la IA: cuando el modelo genera contenido que parece cierto, pero que es totalmente inventado.

Este fenómeno no es un error de funcionamiento, sino una limitación inherente a este tipo de tecnología. Incluso cuando tiene acceso a internet, sigue siendo posible que interprete mal lo que encuentra o lo presente de forma inexacta. De hecho, según las investigadoras del estudio de Columbia, muchos chatbots citan artículos incorrectos, republicaciones o directamente inventan enlaces. A veces se amparan en logotipos de medios reconocidos, lo que puede dar una apariencia de autoridad a una desinformación peligrosa.

Por eso, usar el modelo sin espíritu crítico es cómo construir una casa con ladrillos de cartón: aparenta solidez, pero se desmorona con el más mínimo contacto.

La inmediatez no debe sustituir al criterio

No es casualidad que cada vez más estudiantes, trabajadores y curiosos recurran a ChatGPT para resolver dudas, redactar textos o entender conceptos complejos. La inmediatez es seductora, pero confiar ciegamente en lo que dice una IA es tan peligroso como confiar en un rumor sin verificarlo.

El riesgo no solo es académico, también es profesional. En sectores donde la información precisa es crucial —como el derecho, la medicina, el periodismo o la ciencia—, una fuente falsa puede tener consecuencias mucho más graves que una simple mala calificación. Puede suponer una pérdida de credibilidad, una mala decisión o incluso perjuicios concretos para otras personas.

Por eso, lo primero que debemos cambiar es la mentalidad: la inteligencia artificial no sustituye el pensamiento crítico. Lo complementa. Y para eso, hay que saber cómo usarla.

Cómo usar ChatGPT (y otras IAs) sin caer en sus trampas

La clave está en usar estas herramientas como asistentes, no como oráculos. Aquí van algunos consejos clave para que aproveches ChatGPT (u otras IAs similares) sin caer en la trampa de la desinformación:

1. Desconfía de las citas demasiado genéricas o “perfectas”

Cuando una fuente suena demasiado bien para ser verdad, probablemente no sea cierta. Un apellido común, una fecha reciente y un título que encaja perfectamente con tu tema deberían ser señales de alerta. Antes de incluir cualquier referencia, búscala tú mismo en Google Scholar, en bases académicas o bibliotecas digitales.

2. Pide las fuentes… pero también verifícalas

Puedes pedirle a la IA que te dé las fuentes de lo que te está diciendo, pero no te conformes con eso. Busca si existen, verifica que los autores hayan escrito sobre ese tema, y comprueba que el contenido coincide con lo que se dice.

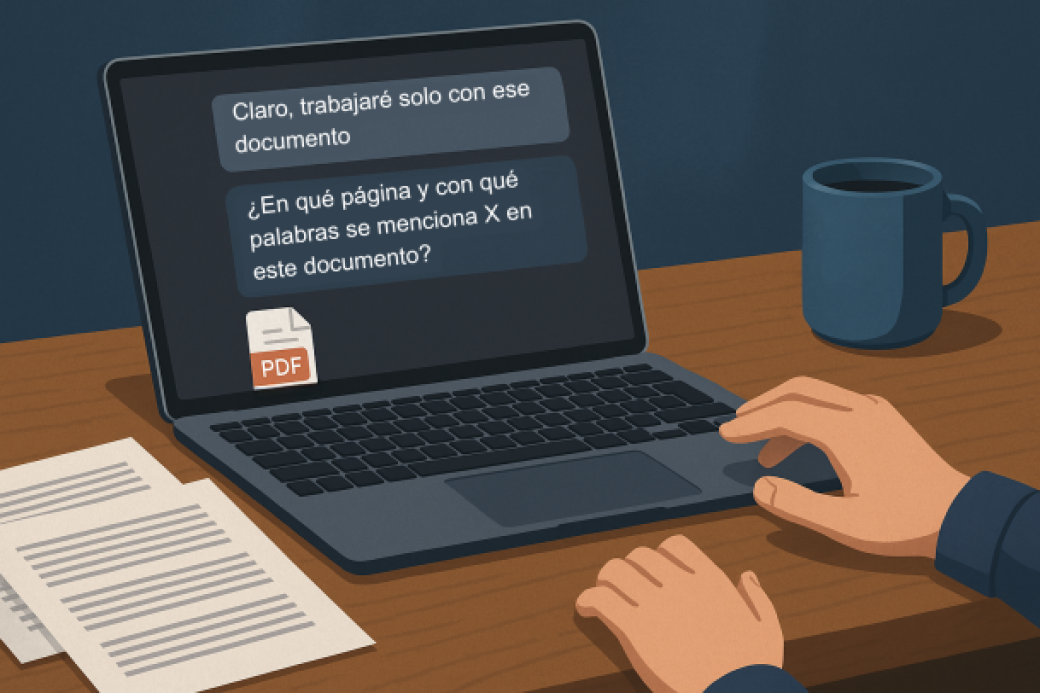

3. Usa documentos reales como base

Una de las mejores formas de usar estos modelos de lenguaje de forma fiable es adjuntar documentos reales (archivos PDF de libros, artículos científicos, informes oficiales, etc.) y pedirle que trabaje solo con esos documentos.

No preguntes “¿qué dice este texto sobre X?”, sino “¿en qué página y con qué palabras se menciona X en este documento?” o “¿aparece esta cita textual en el texto?”. Oblígale a ser preciso.

La calidad de lo que te responde ChatGPT depende de lo claro y detallado que seas al preguntar. Si le dices “Dame fuentes reales sobre el cambio climático”, puede mezclar cosas. Pero si le dices: “Voy a adjuntar un artículo científico. Quiero que respondas a estas preguntas solo usando ese documento, y que me cites literalmente la página o párrafo donde se dice eso”…entonces el modelo trabajará con una guía más clara y reducirás el margen de error.

Pero ojo: aunque le des un documento, puede seguir equivocándose con las citas textuales. A veces reformula en lugar de citar, otras veces mezcla datos. Por eso, tú debes hacer una última revisión.

4. Contrasta y combina IA con herramientas especializadas

Antes de dar por válida una información generada por la IA, búscala por otros medios. ¿Lo encuentras también en medios fiables, artículos académicos, libros, informes oficiales? Si no aparece en ningún lado, desconfía.

Para temas académicos, usa ChatGPT como apoyo pero consulta fuentes como:

- Google Scholar

- PubMed

- Dialnet

- Scopus

- Bibliotecas universitarias

Y para temas más generales:

- Organismos oficiales (OMS, ONU, INE, etc.)

- Medios de comunicación de prestigio

- Portales de datos abiertos

El pensamiento crítico sigue siendo la mejor herramienta

Volvamos al caso del (González, 2015), una cita falsa que parecía real. No fue una mala intención, sino una consecuencia del diseño del sistema. Pero ahí está la lección: no puedes delegar la responsabilidad del conocimiento en una herramienta automatizada.

La inteligencia artificial puede ayudarte a investigar, a redactar, a pensar, pero no puede pensar por ti y mucho menos asumir la responsabilidad de lo que dices, escribes o afirmas.

Como advertía Chandrasekar del estudio de Columbia:

“El modelo actual hace muy difícil para los usuarios analizar lo que es cierto y lo que no lo es. El problema de fondo aquí es que la gente usa estas herramientas pensando que todo lo que leen es verdad y no se acercan con escepticismo”

Así que la próxima vez que uses ChatGPT o cualquier otro modelo para obtener datos o conocimientos, recuerda: verifica, contrasta y piensa por ti mismo. Porque en la era del contenido automático, el pensamiento crítico es más valioso que nunca.