Cuando alguien piensa en un centro de datos, la primera imagen que nos viene a la cabeza son largos pasillos repletos de armarios que alojan un buen número de servidores y que se encuentran en un complejo con un ambiente controlado en el que hace frío para contribuir a un mejor funcionamiento de todos estos computadores.

Un centro de datos es mucho más que servidores, armarios, pasillos fríos y pasillos calientes, es el lugar en el que se almacenan y procesan gran cantidad de datos que hacen funcionar las operaciones de una compañía o dan respuesta a nuestras preguntas cuando realizamos una búsqueda en Internet o subimos una imagen a servicios como Flickr o Facebook.

Los grandes volúmenes de información que se pueden llegar a manejar en un centro de datos hacen que estos tengan que crecer en capacidad de almacenamiento y proceso, una evolución que lleva de la mano la necesidad de reducir el espacio que ocupa nuestra granja de servidores y, cómo no, reducir los costes de operación apostando por una reducción del consumo energético, introducir el uso de energías limpias o introducir sistemas de refrigeración alternativos a los tradicionales sistemas de aire acondicionado.

Sostenibilidad y eficiencia en los centros de datos

El 1% del consumo eléctrico mundial se debe a la actividad generada por los centros de datos, es decir, gastamos el 1% de la electricidad mundial en mantener los servidores que sustentan los servicios disponibles en Internet o los sistemas que se utilizan en muchas empresas y administraciones públicas para su funcionamiento. De hecho, las emisiones de dióxido de carbono provocadas por la industria TIC a nivel global serían equivalentes a un 2% de las emisiones globales y, por tanto, aproximadamente iguales a las de la industria aeronáutica.

Con este contexto, son muchas las empresas que han puesto el foco en gestionar de manera mucho más eficiente sus infraestructuras con la idea de optimizar costes, minimizar el impacto ambiental y garantizar la máxima ocupación de la capacidad de proceso que tienen desplegadas. Aspectos como la virtualización y la consolidación de centros de datos (o una progresiva reducción en el número como es el caso de muchas administraciones públicas como el Gobierno Federal de Estados Unidos o el Reino Unido) son prácticas muy comunes, sin embargo, hay empresas que están explorando nuevas sendas que permiten construir centros de datos mucho más sostenibles.

Google, por ejemplo, concentra el 0,01% del consumo eléctrico mundial (o el 1% del consumo eléctrico de la industria) hace tiempo que trabaja en la línea de optimizar sus centros de datos gracias a la adopción de energías renovables, el desarrollo de nuevos sistemas de refrigeración. Otra de las iniciativas del gigante de las búsquedas es la apuesta por el desarrollo de su propio hardware y sus granjas de servidores están repletas de servidores muy simples y extremadamente optimizados que huyen de los estándares de mercado y los grandes fabricantes, con la idea de maximizar el uso de la infraestructura y minimizar al máximo el consumo.

Esta nueva forma de entender el centro de datos y «construirlo a medida» es algo que también ha llegado otros grandes players de la red como Facebook. No hace mucho, la red social de Mark Zuckerberg inauguró un centro de datos en Suecia que tiene la particularidad de que el 100% de los servidores desplegados han sido diseñados por la compañía y, por tanto, no son servidores comerciales. Estas 10.000 máquinas proceden de un proyecto impulsado por Facebook que, poco a poco, va atrapando a cada vez más gente con la idea de desarrollar hardware de manera abierta con diseños optimizados que permitan desarrollar una nueva generación de centros de datos sostenibles y eficientes: el Open Compute Project.

[youtube]http://www.youtube.com/watch?v=p4D9UNXKGV4[/youtube]

Open Compute Project: llevando el DIY al centro de datos

Popularmente conocemos el do-it-yourself o DIY como «construir algo con nuestros propios medios», una idea que es muy popular, por ejemplo, en el desarrollo del hardware libre. El Open Compute Project sigue la senda de construir el hardware de manera abierta compartiendo diseños y especificaciones y dando un giro al diseño y construcción de servidores.

El proyecto, que lleva en marcha desde 2011, tiene como objetivo desarrollar servidores en un entorno abierto para construir computadores que optimicen el consumo energético o la disipación de calor, eliminando aspectos superfluos y que, generalmente, no se usan para ajustar las especificaciones del hardware a su utilización y, por tanto, huyendo de las arquitecturas y sistemas de propósito general.

Si bien empresas como Google o Facebook no tienen capacidad de fabricación, estas compañías recurren a terceros que les fabrican los servidores siguiendo los diseños y especificaciones que les entregan para que, en conjunto, el resultado permita ahorrar en costes de operación, reducir el consumo energético y, por tanto, minimizar la huella de carbono del centro de datos (y solamente Facebook mantiene 11 centros de datos en Estados Unidos).

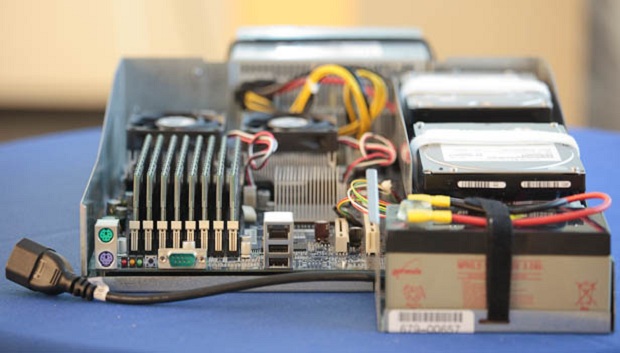

¿Y qué tienen de malo los servidores comerciales? Los servidores comerciales son sistemas de propósito general que intentan cubrir un amplio espectro de aplicaciones y casos de uso, una flexibilidad que en el caso de estos centros de datos dedicados no es necesario y, en algunos aspectos, perjudica a las operaciones. Algo tan simple como el logotipo del fabricante del servidor que encontramos en el chasis del mismo, según los ingenieros de Facebook, afecta a la disipación de calor y provoca que los ventiladores giren más y se consuman unos 25 vatios de energía extra.

Eliminando aplicaciones de gestión de los fabricantes, los «adornos superfluos» y otros aspectos, Facebook es capaz de ahorrar alrededor del 24% del coste de su infraestructura (lo cual es un ahorro considerable cuando manejamos grandes volúmenes de hardware y, además, al optimizar el consumo energético son capaces de reducir alrededor del 38% de los gastos de operación.

Un nuevo reto para la industria

Esta nueva forma de dimensionar el hardware de un centro de datos ha dado sus frutos en forma de diseños de sistemas de almacenamiento, placas base, servidores o, incluso, bastidores en los que alojar los servidores.

[youtube]http://www.youtube.com/watch?v=Plu54ng9Zqg[/youtube]

Quizás, alguien pueda pensar que este nuevo paradigma de diseño es un ataque frontal a los fabricantes tradicionales y, prácticamente, los aparta de la circulación. Sin embargo, el Open Compute Project está sentando las bases de una nueva forma de entender el centro de datos y las infraestructuras sobre las que construir una nube empresarial o sobre la que ofrecer servicios a terceros; una base en la que se huyen de las soluciones generalistas y se buscan infraestructuras que encajen a la perfección en nuestras aplicaciones de manera casi artesanal.

Para los fabricantes tradicionales el Open Compute Project es un reto que requiere flexibilidad en las líneas de fabricación, una flexibilidad que se traduce en la recepción de una serie de especificaciones de fabricación en vez de recibir un pedido de 10.000 servidores con una configuración determinada dentro de las posibles que ofrece un fabricante.

Esta flexibilidad, en el fondo, está abierta a todos los fabricantes y se abre la puerta a una nueva forma de entender el negocio, mucho más cercana al cliente y en la que pueden participar los actores que, hasta la fecha, suministraban centros de datos de todo el mundo puesto que en las grandes infraestructuras se tiende a diversificar los fabricantes para minimizar la probabilidad de fallo.

Minimizar costes y mejorar la eficiencia energética de las grandes infraestructuras de hardware, un reto en el que el Open Compute Project tiene mucho que decir a la hora de configurar los centros de datos del futuro.

Imágenes: CNET y Open Compute Project