La mayoría estamos acostumbrados a interactuar con modelos de inteligencia artificial generativa a través de sus asistentes de IA. Me refiero a aplicaciones tan populares como ChatGPT, Gemini, Copilot, Claude, Le Chat o Meta AI. Las instalas en tu teléfono móvil u ordenador, o accedes a ellas desde tu navegador y mantienes una conversación por escrito o por voz para que resuelva dudas, te sugiera ideas y otras tareas variadas. Pero los profesionales o expertos en IA necesitan sacarle más provecho. O tener más control. Y para ello tienen dos opciones, además de usar los asistentes: acceder a la API de estos modelos de IA o instalarlos en sus ordenadores. Sí. Puedes instalar inteligencia artificial en tu PC.

En primer lugar, hay que dejar claro que no todos los modelos de inteligencia artificial se pueden instalar en tu PC. La razón principal es porque sus propietarios no lo permiten. Están en su derecho. Así que solo puedes usarlos online. Conectando con sus servidores. Pero existen modelos de código abierto, y con licencia libre, que sí permiten descargarlos e instalarlos. Los principales son Llama (de Meta), DeepSeek, Phi (de Microsoft), Gemma (de Google) o Mistral. Si tienes un ordenador potente y quieres trastear con la inteligencia artificial, o usarla sin conexión, herramientas como Ollama o LM Studio facilitan esta tarea.

Utilizar una inteligencia artificial a través de su asistente oficial tiene sus ventajas. La principal es que funciona a través de Internet, así que no dependes de la potencia de procesamiento de tu teléfono, tableta u ordenador. Y puedes buscar información actual. La desventaja es, precisamente, que esa conexión deja rastro. Así que no puedes estar 100% seguro de que tus conversaciones con la IA no serán accesibles por terceros. Por contra, instalar inteligencia artificial en tu PC tiene la ventaja de que puedes usarla sin conexión a Internet. Además, puedes saltarte sus bloqueos y tener más control sobre la IA. La desventaja, en cambio, es que necesitas un ordenador potente con suficiente RAM, una buena GPU y espacio de almacenamiento. Y que, por defecto, no hará búsquedas online, salvo que configures la IA para ello.

Instalar inteligencia artificial en tu PC con Ollama

Aunque el proceso de instalación de un modelo LLM, lo que llamamos inteligencia artificial, se puede hacer manualmente, herramientas como Ollama o LM Studio facilitan el proceso. Para esta ocasión, elegiremos Ollama. Es una de las más recomendadas, y aunque no tiene interfaz gráfica y funciona en modo comandos de texto, es realmente fácil de usar. También es gratuita, de código abierto. Y puedes instalar esta herramienta en Windows, macOS, Linux o en una imagen Docker en tu servidor o NAS.

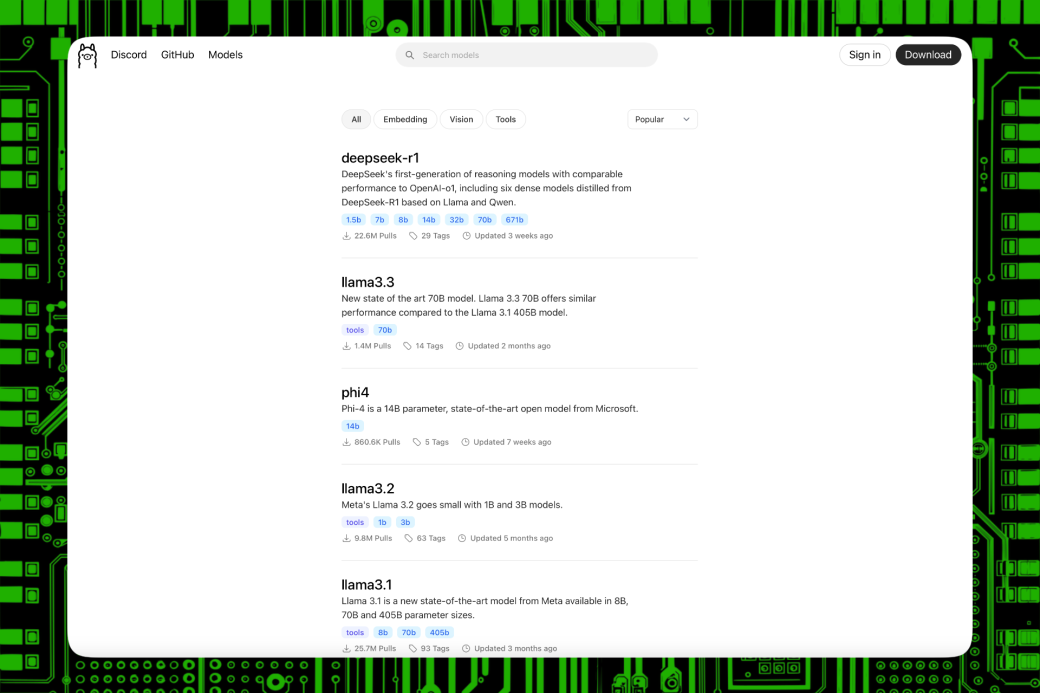

Otra de sus ventajas principales es que ofrece varios modelos de inteligencia artificial ya preparados para instalar. Así puedes elegir entre diferentes tamaños para adaptarse al PC que tengas en casa o en tu oficina. Por ejemplo, puedes probar DeepSeek-R1 en su versión 7B. O lo que es lo mismo, 7.000 millones de parámetros. Ocupa 4,7 GB y, para funcionar, necesita un PC con 8 GB de RAM. O, si quieres probar su versión más completa, su versión 671B, o 671.000 millones de parámetros, necesitarás un PC con 404 GB libres y más de 32 GB de RAM. Lo mismo ocurre con Llama, Phi o Gemma. Según la versión que elijas, a más complejidad, más memoria y espacio de almacenamiento necesitarás.

La potencia de la tarjeta gráfica también influye en que la inteligencia artificial que instales funcione responda más o menos rápido. Para un modelo de IA de 8B de parámetros, necesitarás una GPU de 4 GB de VRAM. Y de 16 GB de VRAM si instalas un modelo más complejo, de 32 B de parámetros. Para ejecutar DeepSeek-R1 671B, la versión más completa, se necesitan varias GPU y más de 1 TB de VRAM. Ten en cuenta que si empresas como Microsoft, Amazon, Meta u OpenAI emplean tanto dinero en centros de datos y servidores para ejecutar sus modelos de inteligencia artificial no es por capricho. Los modelos más complejos necesitan máquinas más potentes.

Instalando una IA, en modo local, en tu ordenador

La única complejidad de instalar inteligencia artificial en tu PC usando Ollama es que todo se hace con comandos. No tiene interfaz gráfica con menús desplegables ni botones. Pero esto no tiene por qué ser un problema. Al contrario, prescindir de una interfaz permite que Ollama sea más ligero y dedique los recursos a la IA, que es la necesitará toda la potencia de tu ordenador.

Así que lo primero que haremos es descargar e instalar Ollama. Como vimos antes, tiene instalador para Windows, macOS y Linux. Una vez instalado, tendremos que abrir el terminal, línea de comandos, PowerShell o la app que utilices para ejecutar comandos en tu sistema operativo. Y lanzar el comando ollama -v para comprobar que está instalada.

Segundo paso. Elegir qué modelo de inteligencia artificial quieres instalar. En el momento de escribir estas líneas, puedes elegir entre DeepSeek, Llama, Phi, Mistral, Qwen, Gemma y otros modelos, algunos de ellos adaptaciones de Llama para tareas específicas o en versiones más reducidas para funcionar en cualquier ordenador. Cada modelo de IA tiene su propia ficha explicativa para saber más de ese modelo, sus parámetros, etc. En este documento encontrarás una lista de los modelos de IA más populares, con qué cantidad de parámetros puedes usarlos, el espacio que ocupan en disco y el comando necesario para instalarlos.

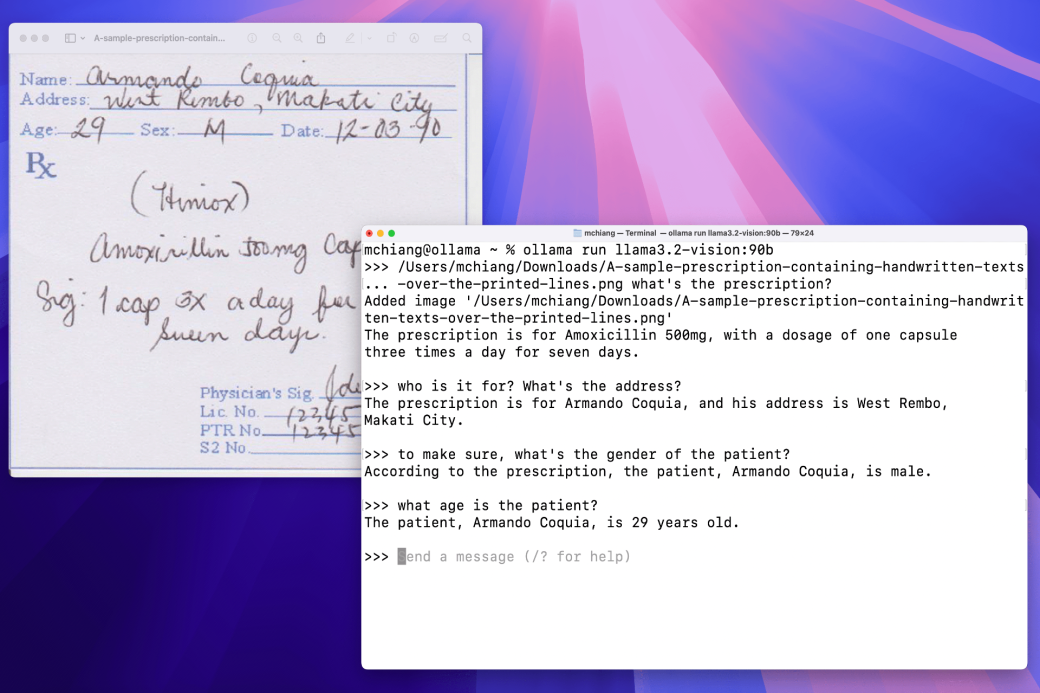

Cuando sepas qué modelo quieres, para instalar esa inteligencia artificial en tu PC bastará con introducir el comando adecuado. Por ejemplo, ollama run deepseek-r1:8b para instalar DeepSeek-R1 en su versión 8B. Si todo va bien, verás que el terminal o línea de comandos muestra información sobre la descarga: porcentaje de completado, cantidad descargada, cantidad total a descargar, velocidad de bajada, tiempo estimado, etc.

Tras la descarga, Ollama instalará ese modelo de IA y lo pondrá en marcha para que puedas usarlo desde ya. Si todo va bien, verás aparecer la palabra success en el terminal. Y, debajo, un mensaje indicando que ya puedes hablar con la IA que has instalado. El funcionamiento de Ollama es igual al de un asistente de IA. Simplemente, hablarás con la inteligencia artificial desde el cuadro de comandos. Encontrarás más información en la documentación oficial de Ollama.

Si te ha gustado este artículo y quieres recibir más contenido sobre innovación y tecnología directamente en tu correo, suscríbete a nuestra newsletter y mantente siempre actualizado. No somos de los que llenan tu bandeja, solo compartimos los lunes.