La inteligencia artificial (IA) en la actualidad no solo emula con gran destreza las habilidades humanas, sino que también sobrepasa con creces capacidades que antaño se creían inalcanzables. Las arquitecturas neuronales llamadas Transformers (el motor de chatGPT) junto con los modelos de difusión latente (el cerebro sintético detrás de MidJourney), han puesto el mundo patas arriba. El campo de la IA está progresando a un ritmo vertiginoso y sus consecuencias sociales se hacen sentir incluso en la calle. El ritmo de generación de nuevas industrias es notablemente alto, y su impacto en el mercado laboral no va a ser menor.

La singularidad ya está aquí y estamos viviendo un cambio de paradigma

En un torbellino de eventos, Geoff Hinton, considerado uno de los padres del aprendizaje profundo (deep learning, DL), renunció a su afiliación en Google para poder hablar abiertamente sobre los riesgos de la IA, sin estar sujeto a las presiones de la empresa.

Gary Marcus, un conocido defensor de la IA simbólica en contraposición al DL, escribió un ensayo titulado “Deep learning is hitting a wall”, sólo para dar un giro de 180º y apoyar la carta abierta (junto con más de 27.000 científicos) que insta a la industria tecnológica a hacer una pausa de experimentos de IA utilizando modelos generativos de lenguaje. Dejó de lado su conocida rivalidad con Hinton en favor de abogar por la necesidad de regular la IA.

Menos de dos meses después, Sam Altman (OpenAI), Gary Marcus y Christina Montgomery (IBM) debatieron en el Senado de los EE. UU. sobre cómo regular la IA para mejorar la seguridad. En otro giro casi cómico, Altman pasó de promover la inteligencia artificial general (AGI) a ayudar formalmente a regular el campo. Una carta subsiguiente titulada “Statement on AI Risk”, respaldada por Hinton, Altman entre otros científicos, equipara las capacidades de la IA con peligros tales como la energía nuclear o una pandemia.

Otros científicos destacados, como Yann LeCun (Meta), respondieron de inmediato con argumentos de lo mas diverso: hablar de AGI es prematuro, que la declaración sobre riesgos es ambigua, que hay otras prioridades o que los beneficios que la hipotética AGI proporcionaría superarían los riesgos. Mientras tanto, el grado de sofisticación de sistemas de IA programados para la toma de decisiones es tal que ya puede engañar a cualquiera, incluidos profesionales de la propia materia.

Para muchos, ya vivimos en la singularidad, la hipotética aceleración exponencial e irreversible del avance tecnológico que superaría a la inteligencia humana. Las consecuencias serían muy difíciles de predecir a cualquier nivel, tanto tecnológico como societal. Para un observador no entrenado en la materia, podría parecer que el reciente auge de la IA puede atribuirse casi exclusivamente a avances científicos seminales en este campo. Sin embargo, al examinar con tiento y calma, se hace evidente que la IA ha recibido una influencia sustancial de campos como la neurociencia y la psicología. En esta entrada, exploramos la relación entre estas tres disciplinas, exponiendo algunas de las filias y fobias entre estos tres campos.

Cómo construir un agente inteligente: contribuciones desde IA, neurociencia y psicología

La IA ha sido durante mucho tiempo un tema de fascinación y debate. Científicos e ingenieros han buscado replicar las capacidades de la inteligencia humana en máquinas. A primera vista, uno podría considerar “lógico” examinar qué sabe la neurociencia y la psicología sobre comportamiento inteligente para así poder crear por ingeniería inversa una IA.

Después de todo, la inteligencia está intrincadamente ligada al cerebro animal y, al comprender su funcionamiento, podemos intentar emularlos de manera artificial. ¿Fácil, verdad? En un artículo reciente, un numeroso grupo de científicos, incluida una extensa lista de neurocientíficos e informáticos, entre ellos Yan LeCun, Yoshua Bengio y Terrence Sejnowski, sugieren que es la neurociencia la disciplina que acelerará la IA en los próximos años:

“La influencia de la neurociencia en la formación del pensamiento de von Neumann, Turing y otros gigantes de la teoría computacional rara vez se menciona en un plan de estudios típico de ciencias de la computación. Las principales conferencias de IA, como NeurIPS, que antes servían para mostrar los últimos avances tanto en neurociencia computacional como en aprendizaje automático, ahora se enfocan casi exclusivamente en este último. Incluso algunos investigadores conscientes de la importancia histórica de la neurociencia en la configuración del campo a menudo argumentan que ha perdido su relevancia”. Y cómo no, las disputas en Twitter no se hicieron esperar. Es justo decir que las afirmaciones actuales de Neuro-AI han escalado en intensidad en relación con las anteriores.

Al otro lado del río, los manifiestos de IA sobre neurociencia muestran un marcado desdén, similar al mismo que la neurociencia alberga hacia la psicología. Jurgen Schmidhuber, una figura prominente en el campo del aprendizaje automático y la IA, compartió recientemente la “Annotated History of Modern AI and Deep Learning”. Las contribuciones de la neurociencia y la psicología a la IA y al DL ni siquiera son mencionadas. ¿No es irónico que el trabajo seminal sobre el Perceptron encontrara su hogar en la revista Psychological Review?

Samuel Gershman, psicólogo computacional de Harvard, compartió recientemente un artículo muy elocuente: “No fueron los biólogos, abandonados a sus propios métodos, quienes inventaron nuevos conceptos técnicos. No fue el caso que los biólogos simplemente ‘observaran’ la activación de las neuronas y luego inventaran la teoría de la información, el análisis de Fourier, etc. El arsenal teórico provenía de otro lugar, inventado independientemente de los descubrimientos en neurobiología”.

Al revisar los hallazgos originales de Hubel y Wiesel sobre las neuronas simples (neuronas sensibles a estímulos orientados en una dirección específica), apuntaba lo siguiente: “En resumen, las redes convolucionales (covnets) sin duda fueron inspiradas por estudios del sistema visual, pero desde el principio hicieron suposiciones que contradecían directamente los datos biológicos. Esas suposiciones biológicamente implausibles (particularmente la invarianza de desplazamiento) resultaron ser de gran importancia práctica, porque significaba que los pesos podían ser compartidos por filtros convolucionales, reduciendo drásticamente el número de parámetros que necesitaban ser aprendidos”. Concluye que la convergencia entre los diferentes campos tal vez sea la respuesta: “Afortunadamente, los algoritmos optimizados para resolver problemas de ingeniería a menudo resultan ser modelos exitosos de la función cerebral. Esto es motivo de optimismo acerca de futuras sinergias entre IA y biología”.

Tomando como ejemplo la naturaleza: como las células de rejilla inspiran la IA

Bien, propongámonos ahora intentar simular una IA utilizando la neurociencia y la psicología como inspiración. Como en nuestros años de universidad, imaginemos que tenemos que completar la siguiente prueba: por favor define un conjunto de parámetros y una arquitectura neuronal para generar un IA, y justifica tu respuesta.

Lo más probable es que terminemos redescubriendo el problema de la degeneración. La degeneración ocurre cuando arquitecturas neuronales completamente dispares logran producir una actividad neuronal o una conducta muy similar. Es como descubrir que tanto nuestra tostadora como nuestra plancha, de alguna manera, preparan la tostada matutina. Objetos diferentes, misma función.

Es ampliamente conocido que la exploración de ‘espacio de parámetros’ funciona por ensayo y error. Implica generar una variedad de combinaciones, probarlas y observar si alguna combinación produce el resultado deseado. Invitamos al lector ávido explorar el fantástico trabajo de Eve Marder a este respecto. Esto podría ayudarnos a comprender cómo diferentes cerebros y sus correspondientes implementaciones de IA, a pesar de poseer distintas propiedades de circuitería, pueden exhibir comportamientos idénticos. Daños en diferentes partes del tracto cortico-espinal pueden resultar en el mismo trastorno de movimiento.

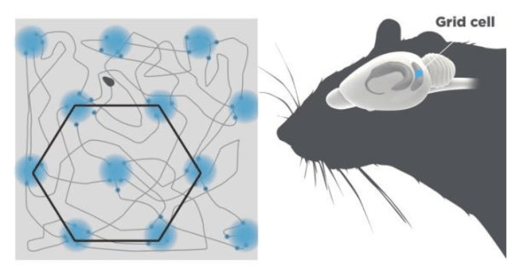

Las discusiones recientes sobre las condiciones exactas en las que se pueden simular las células de rejilla parecen adentrarse de pleno en el problema de la degeneración. Las células de rejilla son neuronas en la corteza entorrinal medial, la interfaz entre el hipocampo y la corteza. Estas neuronas se activan con un patrón similar a una cuadrícula a medida que un animal se mueve, proporcionando un sistema de coordenadas interno para la navegación y la memoria (Figura 1).

Inspirados en este revolucionario hallazgo descubierto por John O’Keefe, May-Britt Moser y Edvard Moser, (tres psicólogos galardonados con el Premio Nobel en Fisiología en 2014), el equipo de DeepMind publicó un impactante artículo en 2018 donde desarrollaron un agente artificial basado en éste tipo de neuronas. Vale la pena mencionar el mérito de dos indies computacionales, Christopher Cueva y Xue-Xin Wei, los cuales publicaron hallazgos notablemente similares el mismo año (y no fueron citados en el artículo de DeepMind publicado en Nature). Del mismo modo en que Oasis eclipsó a Blur, el artículo de Cueva y Wei recibió mucha menos atención desafortunadamente.

Recientemente, un artículo presentó una teoría general sobre la formación de células de rejilla utilizando técnicas de aprendizaje profundo para entrenar redes que exhiben patrones de actividad de rejilla biológicamente realistas. Al evaluar de manera crítica esta teoría, un grupo de investigadores del MIT, encabezados por Raylan Schaeffer e Illa Fiete, desafiaron las conclusiones iniciales del estudio original.

El equipo de MIT muestra de manera convincente que mientras el 90% de las redes artificiales creadas en el estudio original permiten al agente artificial navegar por un entorno virtual, solo el 10% de estas redes neuronales artificiales mostraron patrones de actividad celular similar al de las neuronal de rejilla. En una palabra, degeneración: misma función (navegar por un entorno) se puede implementar por mecanismos diferentes (usando neuronas con y sin patrón de rejilla).

Al restringir la red artificial con parámetros conductuales y biológicamente plausibles, el equipo de MIT proporcionó un modelo más realista sobre la navegación utilizando el patrón de rejilla. La respuesta del equipo de Stanford no tardó en llegar. Parafraseando al tío Ben: “Un gran modelo conlleva una gran responsabilidad…”, además de descartar variables como la degeneración.

La atención en humanos y máquinas: ¿un mismo nombre para realidades diferentes?

Diego Lozano

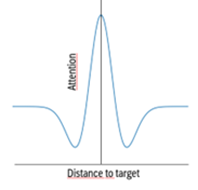

Otro ejemplo reciente de cómo la IA, la Neurociencia y la Psicología están entrelazadas es el mecanismo de «auto-atención» (self-attention) dentro de la arquitectura Transformers. En palabras de Alex Graves, destacado científico experto en DL: «La atención introspectiva o interna nos permite atender a un pensamiento a la vez para recordar un evento, en lugar de todos los eventos. Y creo que la idea crucial que quiero que te lleves de esto es que la atención se trata de ignorar cosas. No se trata de introducir más información en una red neuronal. En realidad, se trata de eliminar parte de la información para que sea posible centrarse en partes específicas«. Es una definición en términos de Psicología Cognitiva clásica. Lo interesante, y el comienzo de la divergencia entre la IA y la Psicología, radica en parte en los detalles de su implementación. En Psicofísica es bien sabido que la detección de un estímulo varía en función de la ubicación espacial. Este es el modelo del sombrero mejicano. El modelo muestra que nuestra atención es intensa en el foco, disminuye conforme nos alejamos del estímulo que procesamos para luego aumentar moderadamente para las cosas que están más lejos.

Por otro lado, el «foco» del mecanismo de auto-atención en Transformers puede ser visto como un proceso de búsqueda utilizando un gran catálogo de libros. Alison Gopnik, una destacada psicóloga del desarrollo infantil, aporta una analogía esencial al entender estos grandes modelos de lenguaje como «tecnologías culturales». Para ella, los grandes modelos de lenguaje (large-language models), «son nuevas técnicas para transmitir información de un grupo de personas a otro. Preguntar si GPT-3 o LaMDA son inteligentes o saben sobre el mundo es como preguntar si la biblioteca de la Universidad de California es inteligente o si una búsqueda en Google «sabe» la respuesta a tus preguntas».

Hacerle una pregunta a ChatGPT sería como una forma sofisticada y eficiente de recuperar un fragmento de texto del libro con más páginas del mundo. La capacidad del modelo para generar nuevo texto está relacionada con su incapacidad para memorizarlo todo. Apoyándome es su idea y para explicar cómo funciona el mecanismo de auto-atención, imaginemos que estamos trabajando en una biblioteca gigantesca y necesitamos encontrar información específica para terminar un ensayo para el cole.

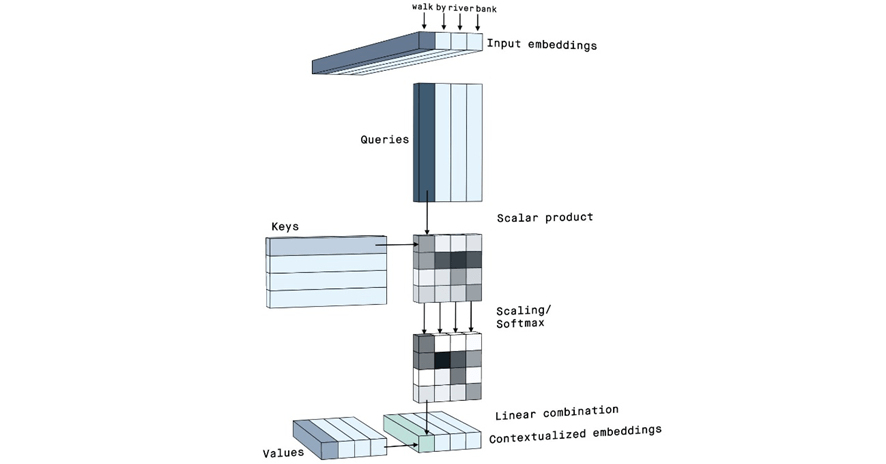

Esta biblioteca tiene un sistema de organización único e inteligente que utiliza una combinación de un catálogo, un casillero y un bibliotecario. En esta analogía, los libros son los valores (V). Son el contenido real que queremos leer para completar nuestro ensayo. El catálogo es la clave (K) y contiene una referencia a la ubicación de cada libro en la biblioteca. Cada entrada consta del título del libro y su ubicación exacta en la biblioteca gigantesca. Luego necesitamos formular una consulta (Q). El trabajo del bibliotecario es buscar la ubicación del libro que necesitamos consultando el catálogo. Ahora, imaginemos que estamos tratando de entender el contexto de una frase como: «La IA no respeta la psicología». Como modelo transformador de IA, queremos entender el significado de «IA» en este contexto. Así que «IA» es la consulta en este caso. El bibliotecario (la consulta Q) va al catálogo (las claves K) y busca «IA». El catálogo da una referencia a todos los libros (Palabras/Valores, V) relacionados con «IA» – podría apuntar a los libros titulados «Deep Learning, Goodfellow», «National Geographic» y «Dragon Ball».

Y finalmente, el mecanismo de auto-atención. Es la forma en que la red neuronal calcula la relevancia de cada libro relacionado con la consulta original. Por ejemplo, podría decidir que, «Deep Learning, Goodfellow» es el más relevante, «National Geographic» es algo relevante, y «Dragon Ball» es irrelevante. Esto se hace asignando una puntuación de importancia a cada libro. Estas puntuaciones de importancia se determinan tomando el producto escalar de la Consulta Q y las Claves K, seguido de una operación llamada SoftMax, que asegura que la suma total de las puntuaciones de importancia es igual a uno.

El mecanismo de auto-atención recupera los libros relevantes (V), multiplica cada uno por su puntuación de importancia correspondiente, y los combina para producir una representación contextual de la palabra original («IA», ver Figura 3). Esto es muy diferente del modelo del sombrero mejicano de la psicología. Introducir una función de sombrero mejicano en lugar de una operación SoftMax haría los dos procesos un poco más similares. Se recomienda al lector interesado revisar recientes revisiones en el tema para profundizar, incluyendo una entrada de blog que señala errores en la famosa figura del artículo de 2017.

En este punto podemos preguntarnos si consideramos este mecanismo como un proxy de la inteligencia. El equipo de Gopnik argumenta que mientras los grandes modelos de lenguaje pueden reproducir competencias particulares, como producir texto gramatical en respuesta a un estímulo, pueden no ser capaces de desarrollar estas habilidades a través de la innovación. Definen la innovación como la capacidad de expandir, crear, cambiar, evaluar y mejorar el conocimiento y las habilidades existentes. En su opinión, la innovación desafía el status quo y cuestiona la sabiduría convencional que es el corpus de entrenamiento para los sistemas de IA. De hecho, los niños son capaces de aprender tanto por imitación como por innovación, sugiriendo que las máquinas pueden necesitar algo más que un entrenamiento basado en toneladas de texto para lograr lo que un niño de pocos años es capaz de deducir en poco tiempo. Esta conclusión tiene apoyo empírico, ya que se pueden diseñar nuevas técnicas de estímulo para «recuperar» de manera más fiable las fuentes originales de los datos pre-entrenados.

Concluyendo, la relación intrincada entre la IA, la neurociencia y la psicología que hemos explorado aquí refleja una fascinante convergencia de distintos ámbitos científicos. Cada una de estas disciplinas, a su manera, aporta valiosas perspectivas y enfoques a nuestra comprensión del cerebro, la mente y los complejos procesos que subyacen a la inteligencia y la conciencia.

La exploración de la IA, la neurociencia y la psicología como campos interconectados revela el potencial inigualable de sus aportaciones combinadas. El tira y afloja entre estas disciplinas no solo alimenta el descubrimiento científico, sino que también impulsa la innovación tecnológica a un ritmo sin precedentes. Es evidente que estas disciplinas no pueden progresar aisladas las unas de las otras. La IA necesita de la neurociencia y la psicología para construir máquinas que estén más alineadas con cómo funciona la inteligencia humana. Al mismo tiempo, la IA proporciona a la neurociencia y la psicología modelos computacionales únicos para probar teorías y explorar las complejidades de la mente humana.

Imagen de cabecera de Brand Factory.