La conferencia de Darmouth, celebrada en 1956, es considerada la cuna de la inteligencia artificial. Allí, algunos de los que después serían los científicos informáticos y matemáticos más importantes de todos los tiempos, se reunieron durante ocho semanas en la universidad perteneciente a la Ivy League del mismo nombre y fijaron las bases que han llevado este campo, conceptual y materialmente, hasta el lugar que ocupa hoy.

Cincuenta años después, los miembros de aquel grupo de trabajo se reunieron en el mismo lugar para celebrar su aniversario. Pero su visión sobre lo que la inteligencia artificial podía suponer para todos, había cambiado.

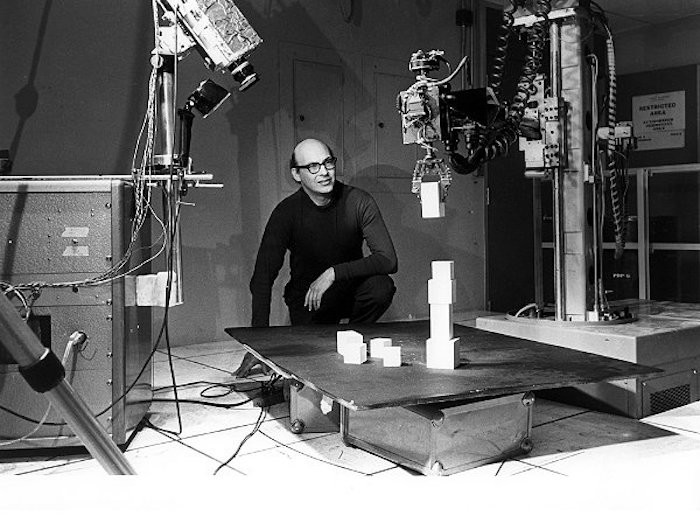

Marvin Minsky, cofundador del MIT, premio Turing, y uno de aquellos padres fundacionales de la IA, había pasado durante esos 50 años de construir la que se considera la primera red neuronal, llamada SNARC, a renegar de ellas.

Cuando fue preguntado por un asistente al aniversario sobre si “era el diablo” por haber combatido lo que parecía que era el mecanismo más potente que tenían las IAs para ser cada vez mejores, Minsky respondió: “Sí, lo soy”.

Los dilemas de la IA, siempre presentes entre sus principales promotores

Minsky falleció 10 años más tarde de aquella respuesta, en 2016, a los 88 años. Durante su brillante carrera, nunca se quitó cierto aire de polémico, pero parecía contraintuitivo que alguien que había puesto las bases de la IA, renegara de las redes neuronales. ¿Quizá porque había imaginado su potencial?

Una red neuronal es un método, construcción y mejora de una inteligencia artificial que enseña a las máquinas a procesar datos de una manera que está inspirada en el cerebro humano. Permite lo que se denomina aprendizaje profundo, que utiliza los nodos como neuronas interconectadas en una estructura de capas. Así, crea un sistema adaptable que las computadoras utilizan para aprender de sus errores y mejorar continuamente.

Es el método sobre el que se cimentan DALL-E 2 o ChatGPT y es lo que parecía asustar también a Minsky quien, no obstante, no ha sido la única gran mente dentro de la IA en exponer sus dudas.

El trabajo de Minsky sobre la inteligencia artificial en los años 50 y 60 ha sido fundamental para el avance de la IA simbólica. Después, fundaría con John McCarthy el Laboratorio de Inteligencia Artificial del MIT a principios de la década de los sesenta. ¿Por qué entonces esa aversión a las redes neuronales?

Para eso hay que remontarse de nuevo a esos comienzos de la IA.

El Perceptrón vs. Minsky: La primera ‘Guerra’ por la IA ocurrió antes de que naciera

En julio de 1958, la Oficina de Investigación Naval de Estados Unidos hizo una demostración del Perceptrón: Un IBM 704 fue alimentado con una serie de tarjetas perforadas y, tras 50 pruebas, el ordenador de 5 toneladas aprendió a identificar las tarjetas marcadas a la izquierda de las marcadas a la derecha.

«Las historias sobre la creación de máquinas con cualidades humanas han sido durante mucho tiempo una campo fascinante en el ámbito de la ciencia ficción. Sin embargo, estamos a punto de asistir al nacimiento de una máquina de este tipo: una máquina capaz de percibir, reconocer e identificar su entorno sin ningún tipo de entrenamiento o control humano», afirmó Frank Rosenblatt, su creador.

El Perceptrón tenía el potencial de lanzar mil redes neuronales primigenias, pero se encontró con un obstáculo. Lo has adivinado: Marvin Minsky.

Minsky puso en duda la utilidad de Perceptrón. Afirmaba que las redes neuronales no podían manejar nada más allá de lo que Rosenblatt había demostrado. Minsky arremetió contra Rosenblatt cada vez que pudo mientras ambos estuvieron con vida.

Minsky y su compañero Seymour Papert intentaron desmontar las ideas de Rosenblatt en el libro de 1969, Perceptrons: An Introduction to Computational Geometry. Aquello funcionó y supuso la paralización de la investigación en el Perceptrón y las redes neuronales durante varios años… Hasta que nuevos investigadores se interesaron por ellas.

En cierto modo, Minsky pareció siempre negarse a ver que aquello que contribuyó a crear fuera en algún momento capaz de competir con la mente humana, a pesar de que seguramente cada vez lo viera más cerca. En parte, porque su visión sobre el cerebro humano se parecía mucho al de aquellas máquinas. “Es degradante o insultante decir que alguien es una buena persona o que tiene alma. Cada persona ha construido esta estructura increíblemente compleja, y si la atribuyes a una perla mágica en medio de una ostra que te hace bien, eso es trivializar a una persona y te impide pensar en lo que realmente está sucediendo”, decía Minsky años después en su libro The Emotion Machine.

Pero volvamos con esos nuevos investigadores que citábamos. A mediados de la década de 1980, Geoff Hinton, un joven profesor de la Universidad Carnegie Mellon y su equipo construyeron una compleja red de neuronas artificiales, abordando algunas de las preocupaciones planteadas anteriormente por Minsky. Insertaron una capa extra de complejidad que permitía a las redes aprender funciones más complicadas. Sin embargo, no tuvo ningún impacto a largo plazo, lo que hizo que las redes neuronales cayeran en desgracia a finales de la década de 1990. En 2006, Hinton mejoró el trabajo previo del investigador Yann LeCun para introducir una nueva técnica llamada aprendizaje profundo o deep learning.

Geoff Hinton, más joven que Minsky y todavía vivo, fue apodado por ello El Padre del deep learning. Su insistencia consiguió poner la base de los sistemas algorítmicos sobre los que se han cimentado buena parte de las tecnologías que usan las actuales grandes tecnológicas, de Google a Meta. Las redes neuronales habían vuelto con más fuerza que nunca.

Y, sin embargo, este nuevo padre de la segunda generación de IAs, también renegaría de ellas.

Al igual que Minsky, los padres del aprendizaje profundo también plantean hoy sus dudas sobre las actuales IAs

Hinton, tras hacer que la IA avanzara en este camino, desconfía también, sin embargo, de cómo se está asentando. En concreto, Hinton cree que el método denominado propagación hacia atrás de errores o retropropagación (del inglés backpropagation), y en el que se basan la mayoría de software actuales más potentes, no es el camino para encontrar una IA realmente avanzada y útil.

En la propagación posterior se usan etiquetas para representar, por ejemplo, una foto o un dato dentro de una capa neuronal que imita al funcionamiento del cerebro. Estas se van ajustando, capa por capa, hasta que la red pueda realizar una función inteligente con la menor cantidad de errores posibles.

Pero Hinton sugirió que, para llegar a donde las redes neuronales puedan volverse inteligentes por sí mismas, “habrá que deshacerse de la propagación posterior. No creo que sea así cómo funciona el cerebro. Claramente no necesitamos todos los datos etiquetados”, dijo en una entrevista con Axios, lo que le lleva a creer que llegará un momento en el que haya que casi “empezar de nuevo con todas las IAs”.

Su nombre no es el único de la segunda hornada de impulsores de la IA que después han planteado sus dudas, tanto tecnológicas como éticas. Hinton recibió en 2018 el premio Turing por sus avances junto con el citado Yann LeCun y Yoshua Bengio, ambos franceses. Este último, a pesar de que sus investigaciones han servido para empresas como Google o Facebook, ha sido el único del trío que ha realizado toda su carrera en la academia, donde elevó sus recelos ante un posible mal uso futuro de esta tecnología.

A finales de 2017, Bengio presentó la denominada Declaración de Montreal (por la Universidad en la que ha sentado cátedra): un conjunto de pautas éticas para la IA donde advierte de los problemas que podrían conllevar sus abusos.

En una entrevista con Nature advertía de que “Mucho de lo que más preocupa con la IA no sucede a plena luz del día. Está sucediendo en laboratorios militares, en organizaciones de seguridad, en empresas privadas que prestan servicios a gobiernos o la policía”.

La Declaración de Montreal de Bengio es hoy reconocida como la primera y más sólida propuesta de acuerdo para prevenir que la IA pueda promover ataques contra la privacidad, la desigualdad o la violencia contra otros estados u organizaciones. Pero, a pesar de haber reunido al apoyo de centenares de empresas y universidades, ninguna de las grandes tecnológicas aparece todavía en su lista de firmantes.