La creación de un algoritmo capaz de rastrear los movimientos de la mano podría devenir en un sistema para traducir el lenguaje de signos en tiempo real.

Una de las posibilidades de la Inteligencia Artificial pasa por las traducciones automáticas de voz y de texto. Es cierto que la precisión, aunque mejora con el paso del tiempo, no alcanza aún un nivel profesional. Pero en un plano comunicativo, y en ciertos idiomas, esta tecnología resuelve bien las necesidades.

Hay lenguas más difíciles que otras, claro. Traducir desde el inglés al francés o al español es relativamente sencillo para un traductor automático. Pero hacerlo desde el árabe o el chino al inglés es significativamente más complicado. Y con el lenguaje de signos la tarea se retuerce aún más.

Hay algunas iniciativas encaminadas a reconocer el lenguaje de signos, pero habitualmente requieren de equipos de alta potencia. Desde el laboratorio de IA de Google han creado, sin embargo, un sistema capaz de generar un mapa preciso de la mano y sus dedos solo con un smartphone.

El sistema se basa en machine learning para captar los movimientos de la mano. La cámara del smartphone y la potencia del propio teléfono son suficientes para detectar incluso los gestos de varias manos. Esto no es nada sencillo, pues en el movimiento los dedos chocan entre sí, se vuelven a colocar y lo hacen todo muy rápido.

Un entrenamiento exhaustivo

Igual que las personas necesitamos estudiar para aprender un idioma, el sistema desarrollado en el seno de Google para traducir el lenguaje de signos necesita entrenamiento. Para optimizar su funcionamiento se ha optado por reconocer la palma, por una parte. A partir de ahí se analizan separadamente los dedos.

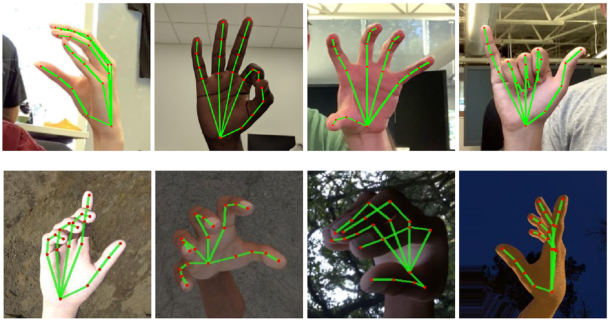

Otro algoritmo se fija en la imagen y le asigna 21 coordenadas. Son puntos que tienen que ver con las posiciones, las distancias de los nudillos y las puntas de los dedos.

Para lograr que esto fuera así se necesitó un entrenamiento exhaustivo. Los investigadores añadieron manualmente estas 21 coordenadas a 30.000 imágenes de manos, con diferentes signos y a distinta luz. Esta base de datos minuciosamente amasada es la que nutre al sistema de machine learning.

Todo ello se utiliza para determinar cuál es la posición de la mano. A partir de ahí, esta se compara con una base de datos de los gestos conocidos. El resultado es esperanzador. Los algoritmos aún tienen que pulirse, pero son una promesa de mejora de los sistemas existentes para traducir el lenguaje de signos. Lo más interesante: la baja necesidad de recursos. Basta con un smartphone y su cámara.

Imágenes: daveynin, Google