¿Qué es la inteligencia artificial (IA)? Para quiénes no lo sepan todavía, la IA es una tecnología que busca emular el comportamiento humano, incluyendo la capacidad de aprender y resolver tareas complejas. Se trata de un objetivo muy ambicioso dentro de este campo de estudio, que avanza a pasos agigantados. El impacto que puede tener el uso de esta herramienta en la sociedad es enorme. Hoy en día, son muchas las compañías que apuestan por la integración de esta tecnología en su día a día, de manera positiva. Sin embargo, no podemos obviar que siempre va a haber personas que hagan un mal uso de esta.

Siendo un problema que ya estamos viviendo con la difusión de fake news (noticias falsas) generadas a través de los large language models (modelos de lenguajes grandes); de video montajes realistas elaborados con deep fakes o la visión túnel provocada por la continua personalización de los contenidos que consumimos. El denominador común de lo anterior somos las personas. Cada uno de nosotros decidimos qué uso hacer de la inteligencia artificial. Razón por la que cada vez es más importante una regulación de esta tecnología para que todos los aspectos positivos que trae consigo no queden en la sombra por malos usos.

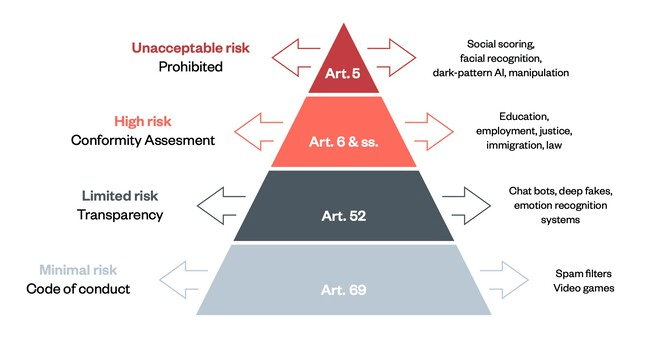

La Unión Europea lleva cerca de dos años trabajando en la primera normativa sobre la IA: Reglamento sobre la IA. Esta ley busca poner fin a futuros problemas con el uso de la inteligencia artificial a través de la regulación de los riesgos de seguridad del sector. La norma distinguirá la aplicación de la IA en función del riesgo que pueda tener sobre los derechos fundamentales.

Según explica Richard Benjamins, Chief AI & Data Strategist, en conversación con el Blog Think Big, habrá un primer nivel de riesgo inadmisible, aquellas aplicaciones que no se podrán llevar a cabo por suponer una amenaza para los derechos fundamentales. En el segundo nivel, estarán recogidos los usos de alto riesgo que se pueden aplicar (como el reconocimiento facial), que tienen que cumplir con unos requisitos estrictos antes de lanzarse al mercado europeo. En el tercer lugar, encontraremos los de riesgo limitado, que tienen que cumplir con la obligación de trasparencia, como es el caso de los asistentes de voz. Y, finalmente, en el cuarto lugar, estarán los usos que implican poco riesgo, por ejemplo, las recomendaciones de canciones, películas, etc.

En ese sentido, cualquier tipo de regulación requiere de años hasta entrar en vigor. El mejor ejemplo es el Reglamento General de Protección de Datos de Carácter Personal (GDPR). «Desde que una ley empieza a definirse para regular un ámbito hasta que entra en vigor, el mundo ya ha cambiado«, expone Richard. En el caso de la IA, esto no es así. El mundo lleva hablando de esta tecnología desde hace tres años, aproximadamente, y la regulación que plantea la Comisión Europea se espera que entre en funcionamiento a principios de 2023.

Telefónica publicó unos Principios de Inteligencia Artificial en 2018, de manera voluntaria y tomando la iniciativa dentro de este ámbito. Richard, junto con otras personas, decidieron que la IA tiene que ser justa; no debe discriminar; tiene que ser transparente con los datos y explicar el porqué de las decisiones, si estas conllevan un impacto en la vida de la gente; tiene que estar al servicio de la sociedad; ser segura y ofrecer privacidad. Y si se trabaja con terceros, estos tienen que adoptar unos principios similares.

Esto ya está siendo implantado en la compañía. Se está nombrando a una persona de referencia en cada equipo para, en caso de tener dudas sobre el impacto ético de una IA, poder acudir a ella. Además, se está trabajando en un piloto de gobernanza en cuatro áreas, que tiene como objetivo crear un reglamento de IA para que entre en vigor el año que viene.

La necesidad de una regulación en la personalización masiva de los contenidos

Toda esa regulación es vital para que la inteligencia artificial tenga el impacto social que deseamos. Muchas veces, no somos conscientes de que estamos usando esta tecnología. Y la realidad es que, cuando vemos una película en una plataforma de contenidos, escuchamos música o estamos en una red social, estamos utilizándola.

Nos encontramos inmersos en una continua sobrecarga informativa que, estos últimos años, ha derivado en la personalización y recomendación de contenidos. Esto es algo útil, hasta cierto punto. Hay un peligro ético al aplicar esta tecnología masivamente, ya que provoca que las personas pierdan la perspectiva de lo que sucede a su alrededor. En otras palabras, nos hemos acostumbrado a leer y a compartir opiniones, en su mayoría, con personas afines a nuestros ideales. Cuando el mundo está repleto de gente, gustos, aficiones, opiniones, etc., muy dispares entre sí.

Este aspecto puede cambiar si se elabora y aplica una regulación en este ámbito. Por ejemplo, en China, existe la Ley de gestión de servicios de Internet para recomendación algorítmica (IISARM) que obliga a las empresas que usan motores de recomendación a otorgar algunos derechos a los usuario. Como la posibilidad de poder desactivar las recomendaciones algorítmicas. Esta norma debería ser aplicable al resto del mundo. «Las empresas tienen que tomar esta decisión por su cuenta. Hay muchas que lo hacen, pero no son todas y el impacto es importante para poder actuar en conjunto«, afirma Richard.

Aplicaciones positivas de los deep fakes

Otro de los aspectos que regulará el Reglamento sobre la IA, elaborado por la Comisión Europea, son los deep fakes. El término viene del deep learning (aprendizaje profundo), que es la técnica predominante en la inteligencia artificial moderna. Este algoritmo muestra imágenes falsas, normalmente, de una persona -también puede ser de objetos o escenarios- que parecen reales. Lo que da lugar a que, en ocasiones, el ojo humano no sea capaz de detectar cuando está expuesto a un deep fake.

Actualmente, una de las claves para detectarlo es prestar atención al parpadeo de la persona. Porque si estamos ante un deep fake, la forma de pestañear de un ser humano sintético -término utilizado para hacer referencia a una persona real que no es la que aparece en el contenido visual- no es la misma que la del ser humano. Las personas solemos parpadear una vez cada 2-8 segundos. Cada pestañeo tiene una duración entre 1 y 4 décimas de segundo. Por lo que, si dudas de si estás ante un deep fake, fíjate en la velocidad de su parpadeo. También se puede observar un desenfoque en el interior de la boca, ya que se trata de una sustitución facial. Así como, puede carecer de sincronización con el sonido y puedes encontrar diferencias entre la cara y el cuello.

A pesar de la creciente preocupación por el uso de esta tecnología, no todo es negro. Desde Telefónica están estudiando formas para detectar cuando nos encontramos ante un contenido falso de este tipo. Además, cada vez hay más noticias que explican cómo los deep fakes pueden ayudar a hacer un mundo mejor.

En conversación con el Blog Think Big, Pablo González, responsable de Ideas Locas, cuenta que, una de las aplicaciones positivas de esta tecnología la podemos encontrar en los asistentes virtuales. «Queremos dotarlos de un trato más humano para que puedan hacer compañía a aquellas personas que lo requieran«, explica. Nos dirigimos hacia un mundo donde un avatar creado por inteligencia artificial podrá impartir una clase online; podremos sumergirnos en una visita guiada online a través de la narración de un avatar; las personas mayores, o cualquier persona que lo necesite, podrá contar con un «rostro amigo» con quién poder charlar.

¿Qué son las redes neuronales generativas?

Pero, ¿cómo es posible la creación de una persona sintética? Los deep fakes utilizan modelos de redes neuronales generativas (deep learning). Esto quiere decir que, enseñamos al algoritmo a crear imágenes de personas no reales tras procesar una base de datos con caras de personas. De manera que, cuando este algoritmo ha sido entrenado con imágenes de una persona concreta, puede generar vídeos realistas con su apariencia.

Diversos ciberdelincuentes han hecho un uso negativo de esta tecnología, afectando desde a rostros públicos, directivos, etc. De ahí, la importancia de ser capaces de detectar cuando nos encontramos ante una deep fake. El futuro de este tipo de IA es enorme y su aplicación en la sociedad puede ser de ayuda en diversos ámbitos. Sin embargo, igual que avanza el aspecto positivo, también aumenta el riesgo del uso de esta tecnología con fines negativos. Razón por la que diferentes empresas, como Google y Telefónica, trabajan para detectar este contenido falso, donde también se encuentran las fake news.

Modelos de lenguajes grandes: una recopilación del conocimiento humano

Otras de las tecnologías que en los últimos años ha comenzado a tener un papel protagonista son los modelos de lenguajes grandes (LLM, siglas en inglés). Estos utilizan la IA para representar el lenguaje de las personas y están entrenados con enormes cantidades datos, a veces a escala de petabytes, que equivale a diez elevado a quince bytes.

Por ejemplo, uno de los casos más sonados y uno de los tipos de lenguajes más importantes, desarrollado por OpenAI, es GPT-3. Este modelo, que cuenta con 175.000 millones de parámetros, puede generar texto autónomamente si se le suministra una introducción o petición en lenguaje natural. De hecho, escribió un trabajo académico de 500 palabras sobre sí mismo Incluyendo citas y referencias científicas en el texto, tardando dos horas en realizar el trabajo.

Esto es posible porque los investigadores ejecutaron el entrenamiento previo del modelo con cantidades ingentes de información disponible en Internet. Desde libros públicos disponibles, toda la Wikipedia, documentos científicos y millones de páginas web disponibles.

Algo similar ha sucedido con el LLM, BERTIN. El segundo modelo de lenguajes grandes para español publicado en 2020 -el primero fue BETO, desarrollado por la Universidad de Chile en 2019-. Para llegar hasta él, tenemos que retroceder hasta 2018, cuando Google desarrolló a BERT. El modelo origen de una subfamilia de modelos grandes adaptados a diversos lenguajes, entre los que está BERTIN.

Este ha sido entrenado con un conjunto de datos, en concreto por un data set que hace un volcado completo de Internet. «De ahí cogimos un trozo de mC4 -el data set– para que aprendiera lo más relevante del español«, explica Paulo Villegas, data scientist en Hogar Digital y una de las personas que participó en la creación de BERTIN, al Blog Think Big.

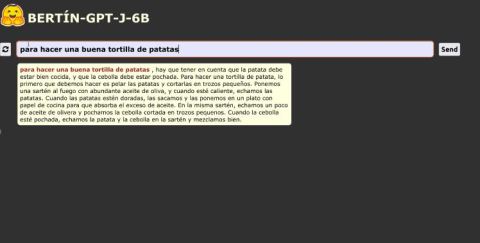

¿Cómo usamos este LLM? En su versión generativa, BERTIN-GPT-J-6B, una persona le pide al sistema que escriba un texto concreto a partir de una entrada. Por ejemplo, como muestra la imagen de abajo, si escribimos el siguiente mandato: «para hacer una buena tortilla de patatas». BERTIN tarda unos cinco o seis segundos en darnos una respuesta mediante el lenguaje que ha aprendido.

Sin embargo, tal y como sucede con los deep fakes, un mal uso de los LLM puede dar lugar a desinformación porque pueden desarrollar cualquier texto que le pidamos, simulando uno veraz. Para hacer frente a esta problemática, hay que trabajar en el ámbito regulatorio, el tecnológico y el social. Paulo declara que, una tarea importante es ser capaces de distinguir cuando nos encontramos ante un texto elaborado por una IA, y cuando no. «Para que su intervención sea obvia y que quede claro para todos los agentes cuál ha sido su papel«, afirma Paulo.

El futuro de la inteligencia artificial

Para concluir hay dos aspectos clave que debemos tener en cuenta cuando nos referimos a la inteligencia artificial. Sobre todo, porque hay cierto desconocimiento por parte de la sociedad en torno a las nuevas tecnologías. Por un lado, la IA no deja de ser una tecnología que llega a nuestra vida para facilitárnosla y que, como tal, al tratarse de una máquina, no puede trabajar completamente sola. Si volvemos al caso del LLM, GPT-3, que elaboró un artículo académico, en el abstract del mismo, una de las investigadoras sostiene que esta tecnología necesita contar con la supervisión de una persona, porque no deja de ser un algoritmo que trabaja con las órdenes que le ha dado un individuo.

Otra parte fundamental y que se sitúa como un reto para la sociedad, especialmente, para las compañías tecnológicas o profesionales de estas, es acercar las nuevas tecnologías a las personas para que puedan ser conscientes de que esta no tiene por qué ser una amenaza para los seres humanos, si se emplea correctamente. Cuanto más se hable de las aplicaciones positivas de la IA, por ejemplo, y más acerquemos este tipo de contenido y casos a la gente, probablemente, mayor será la aceptación por parte de la sociedad.

En cuestión de meses, la Comisión Europea pondrá en vigor la regulación de la inteligencia artificial para regular los usos negativos de la misma. Para conseguir avanzar en materia de tecnología es necesario que su utilización sea para aplicaciones positivas, como las que hemos visto. Solo así conseguiremos progresar.

Imagen de cabecera por Nikotxan.