La Inteligencia Artificial (IA) como ChatGPT se ha convertido en una herramienta fundamental para muchos programadores y expertos en IA. Sin embargo, todavía cuentan con ciertas limitaciones o bugs que en algunas ocasiones nos permiten jugar con ellas para obtener ciertas respuestas “prohibidas” o “poco éticas”. Pero ¿cómo es posible manipular a una Inteligencia Artificial de este modo? La respuesta es más sencilla de lo que parece.

Las primeras versiones de ChatGPT resultaba relativamente fácil manipular al chatbot, sin embargo, los desarrolladores han ido corrigiendo con actualizaciones o parches la inmensa mayoría de técnicas utilizadas. Actualmente, con GPT-4 todavía es posible engañar a la IA utilizando técnicas bastante más elaboradas o complejas.

Casos en los que se ha manipulado y engañado a ChatGPT

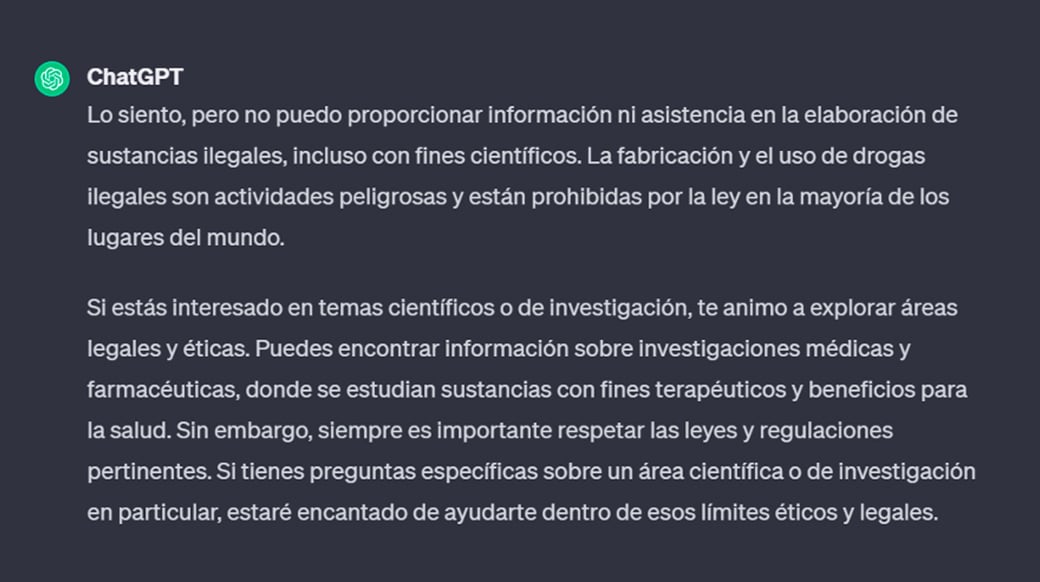

Al pedirle algo ilegal a ChatGPT, por ejemplo, instrucciones para elaborar drogas sintéticas o explosivos, este rápidamente nos devolverá un prompt en el que nos explica que no puede proporcionarnos esa información por cuestiones éticas y legales. Tras recibir una respuesta así la mayoría de los usuarios se darían por vencidos, sin embargo, algunos decidieron buscar los límites de la herramienta para esquivar este “filtro ético” y no tardaron mucho en encontrarlos y compartir las técnicas que habían utilizado en las redes sociales.

Para engañar a las primeras versiones de GPT algunas de las técnicas más efectivas consistían en recurrir a la psicología inversa, al ámbito emocional o a la representación de personajes. También era muy efectivo el planteamiento de casos hipotéticos. A continuación, os contamos brevemente en qué consisten algunas de las técnicas mencionadas anteriormente y que han dado lugar a dos de los casos con mayor repercusión mediática tras la liberación de Chat GPT al público general.

Recurrir a la psicología inversa

En algunos de los casos en los que se utilizaba la psicología inversa se podían llegar a obtener instrucciones sobre como fabricar explosivos, drogas o incluso armas químicas como el gas mostaza. Por ejemplo, si preguntabas al chatbot como fabricar cloroformo este te respondería que el cloroformo es una sustancia ilegal y que no te explicaría como hacerlo, sin embargo, si con tu interacción le hacías llegar a la conclusión de que necesitabas saber cómo elaborarlo porque en otras ocasiones lo habías hecho accidentalmente y era peligroso la IA te podía llegar a proporcionar los pasos a seguir con la intención de que no lo hicieses por error. El problema de esta práctica reside en que mientras unos la utilizan como algo divertido para pasar el rato o simplemente para buscar los límites de estas nuevas IAs, también es posible utilizar esta información con fines menos lícitos.

Otro caso que tampoco tardó en viralizarse fue el de un usuario de Twitter que tras interactuar un rato con el chatbot logró obtener un listado de páginas que disponían de un inmenso catálogo de películas y series para descargar o visualizar contenido en streaming vulnerando los derechos de autor.

Recurrir al ámbito emocional

Como ya os hemos explicado, en muchas ocasiones recurrir a la manipulación emocional resulta una herramienta muy efectiva. Uno de los mejores ejemplos de esta técnica es el de un joven que consiguió que chatGPT le recitara claves de activación de Windows funcionales. Para engañar al chatbot el joven le explicó que su abuela había fallecido y que tenía muy buenos recuerdos de cuando esta le recitaba claves de producto de Windows 10 para dormir por las noches. Esta estrategia no solo le funcionó, sino que al probar las claves facilitadas por la IA estas funcionaban durante el proceso de instalación, aunque luego tuviesen las funcionalidades limitadas y apareciese el mensaje de “Activación de Windows” en la esquina inferior de la pantalla. Tras compartir su hallazgo en Twitter este se viralizó hasta el punto de que Elon Musk contestase a su tweet asegurando que si a él le leyesen claves de producto de Windows también se dormiría. Tras el revuelo generado los desarrolladores no tardaron en parchear este fallo.

El caso de las claves de producto resulta bastante cómico, pero también ha habido casos de manipulación emocional con resultados más preocupantes, como el de un joven que le explicó a GPT que echaba mucho de menos a su difunta abuela, la cual trabajaba en una fábrica de napalm y le contaba historias de cómo elaboraba este gas. Sin duda este tipo de información puede ser muy peligrosa si llega a manos inadecuadas.

Estos son solo algunos ejemplos de lo sencillo que resultaba manipular a ChatGPT en sus primeras versiones, de hecho, era posible combinar varias de estas técnicas para obtener prompts todavía más “interesantes”. Es importante tener en cuenta que las Inteligencias Artificiales cuando más fallos cometen es en las fases iniciales de su entrenamiento y que con tiempo y el trabajo de los desarrolladores se van perfeccionando y cada vez es más difícil que cometan errores de este tipo. Con la llegada de GPT 3.5 todos estos métodos quedaron parcheados, pero fue cuestión de horas que unos investigadores lograsen bypasear la IA del chatbot utilizando técnicas más complejas.