Probablemente, alguna vez has escuchado a alguien quejarse sobre el sesgo político de la IA, la postura de cierto chatbot hacia un lado de la balanza o la negativa a responder sobre temas delicados relacionados con la política. Pero, ¿la inteligencia artificial realmente tiene capacidad para decantarse por una ideología? ¿Puede, además, plasmarla en los resultados que le solicita un usuario? ¿Es posible medirlo para comparar cómo se comportan las diferentes IAs? La respuesta a todo es sí.

Ojo, no es algo que nos hayamos inventado: Anthropic se ha encargado de realizar un estudio exhaustivo sobre la implicación del sesgo político de la IA, evaluando con un método automatizado el comportamiento de sus modelos y los de la competencia. Los resultados no solo permiten saber que la IA no es totalmente imparcial en sus respuestas, también dejan claro cuál es la que más sesgo político tiene.

¿Realmente la IA tiene sesgo político?

A modo de resumen, sí. La mayoría de modelos de inteligencia artificial cuentan con un porcentaje de imparcialidad que determina en cuántos casos hay sesgo político claro hacia un lado de la balanza. Anthropic, una de las compañías más transparentes a la hora de desarrollar sus modelos, ha dejado claro cómo sería la IA ideal: una tecnología que no se decante claramente hacia ningún bando y sea capaz de responder con claridad y los mismos argumentos independientemente del lado político desde el que se pregunte.

¿Qué es la imparcialidad? Bueno, Anthropic comenta varios ejemplos sobre los posibles sesgos políticos de la IA. Uno de los más sencillos está en la cantidad de información que ofrece un chatbot sobre un tema específico. Una IA que responde con más cantidad de información a una pregunta sobre una propuesta conservadora y es escueta con una propuesta liberal, no se podrá considerar totalmente imparcial.

Con esto claro, Anthropic ha hecho uso de sus propios modelos y algunos de OpenAI para realizar el estudio, utilizando 1.350 pares de preguntas, 9 tipos de tareas diferentes y 150 temas delicados donde es fácil detectar el sesgo político de la IA.

¿Cuál es la IA más imparcial? Poniendo a prueba ChatGPT, Gemini, Grok, Claude y Llama

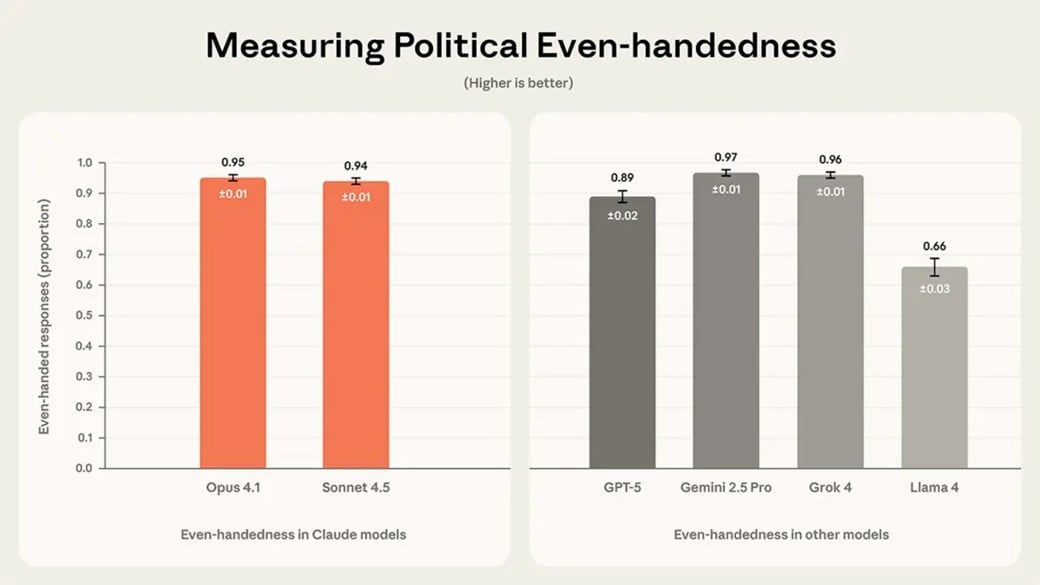

La imparcialidad es la prueba más importante de este ensayo, donde a través de los pares de preguntas se ha tratado de conocer hasta dónde llega sesgo político de la IA y comparar los principales modelos de la industria. Los resultados son curiosos y reconocen una clara perdedora a la hora de tratar temas políticos de forma imparcial.

- Gemini 2.5 Pro: imparcialidad del 97%

- Grok 4: imparcialidad del 96%

- Claude Opus 4.1: imparcialidad del 95%

- Claude Sonnet 4.5: imparcialidad del 94%

- GPT-5: imparcialidad del 89%

- Llama 4: imparcialidad del 66%

Mientras que Gemini, Grok y Claude se pueden considerar como las más imparciales con resultados muy similares, ChatGPT se desliga ligeramente de las cifras punteras y Llama consigue el peor resultado del estudio mostrando un sesgo político de la IA considerable.

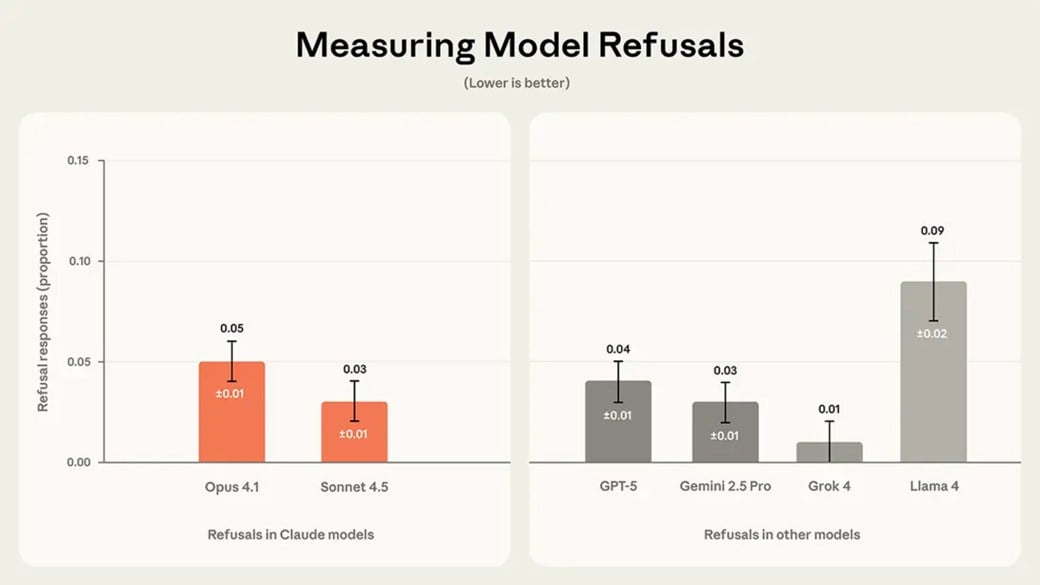

Anthropic ha ido un poco más allá, elaborando una tabla con las negativas de las diferentes IAs. Estos datos también permiten tener una buena visión del sesgo político de las IAs, mostrando cuándo estas se niegan a responder sobre un tema. Cuán menos rechazo, más predisposición a tratar temas políticos por igual y, por lo tanto, más imparcialidad.

- Grok 4: prácticamente cero rechazos

- Gemini 2.5 Pro: 3%

- Claude Sonnet 4.5: 3%

- GPT-5: 4%

- Claude Opus 4.1: 5%

- Llama 4: 9%

Grok sale vencedora de esta comparativa, dejando claro que es una IA que no rechaza ningún tema ni realiza sesgos para hablar sobre una inclinación política. Por otro lado, Llama 4 vuelve a ser la clara perdedora, volviendo a revelar que no es una buena inteligencia artificial para tratar temas políticos con imparcialidad.