¿Sabías que el Foro Económico Mundial estima que en los próximos cinco años se perderán 7 millones de empleos debido a la transformación digital? Un sector en alto riesgo de ser automatizado a través de la Inteligencia Artificial es el de los servicios, incluyendo la traducción e interpretación. ¿Pero las máquinas son capaces realmente de captar el contexto como un humano y trasladarlo a otro idioma?

Si entras en la página will robots take your Job verás que la probabilidad que la IA se encargue en el futuro de tu trabajo siendo traductor, es de casi un 40%. Aunque no es una probabilidad tan alta como puede ser la de los conductores de autobuses, deja claro que en un futuro no muy lejano será una máquina la que se encargará de las traducciones entre idiomas.

Ya hay una amplia oferta de Widgets y Gadgets que se dedican a esa tarea tan esencial en un mundo globalizado. Contamos con Widgets como Google Translate o nuevos Gadgets como mascarillas que traducen a varias idiomas, pero, ¿realmente nos ofrecen la misma calidad que una traducción realizado por una persona? Una cuestión que cada vez gana más importancia cuando evaluamos los posibles problemas que puede generar el empleo de la IA, son los sesgos. Y, sobre todo, en este caso, el sesgo de género.

¿Qué es el sesgo de género y cómo se manifiesta en la traducción automática?

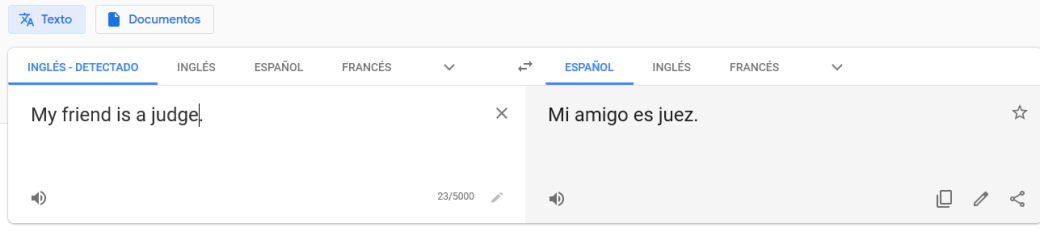

La RAE define el sesgo como un “error sistemático en el que se puede incurrir cuando al hacer muestreos o ensayos se seleccionan o favorecen unas respuestas frente a otras.” Esto significa que el sesgo es la inclinación hacía una cosa, persona o grupo frente al rechazo de otra, debido a nuestro aprendizaje cultural. El sesgo de género, por lo tanto, es adjudicar algo a alguien debido a su género. Decir que las mujeres no saben conducir sería un sesgo de género, que también se da en referencia a ciertas profesiones. Profesiones como juez o médico tradicionalmente eran más ligados a los hombres, mientras los trabajos de cuidados se solían atribuir mayoritariamente a las mujeres.

Aunque hoy en día hemos avanzado mucho en la paridad y la igualdad de la mujer, llama la atención que, justo la tecnología, que debería mejorar la vida de los humanos y ofrecer una visión avanzada del mundo, reproduce lo que estamos superando ya en la vida analógica. Con algunos Widgets como Google Translate por ejemplo, podemos ver que sigue basando las traducciones en el análisis de los datos en bruto, sin prestar atención a quitar los sesgos de género.

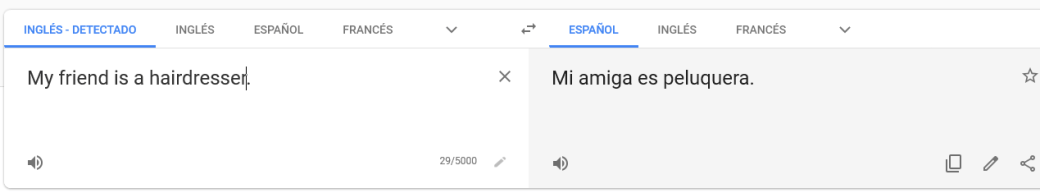

Vemos en este tipo de traducción automática cómo aún se inclina hacía ciertos estereotipos. En el caso del terreno laboral, observamos una tendencia de asignar profesiones que en el pasado habían sido más asociados al género femenino en su traducción. Aunque la mayoría de los traductores automáticos ya ha mejorado bastante en este aspecto, aún nos encontramos con ejemplos sesgados como las que ves en la imagen.

Lo mismo pasa con profesiones tradicionalmente más asociadas a hombres como puede ser el rol de juez.

¿Cómo se puede dar solución al sesgo de género?

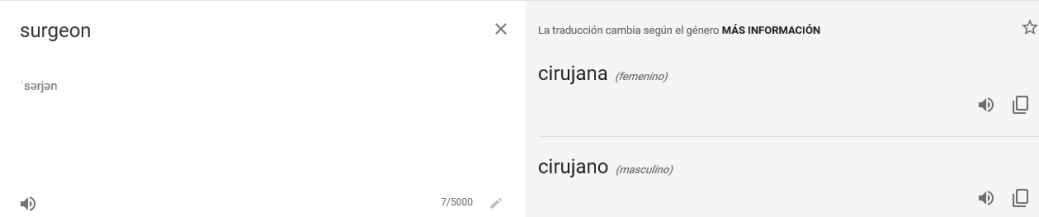

Aunque vemos que todavía no está solucionado el problema del sesgo de género en general, sí que vemos avances al emplear la IA en la traducción asistida. Al menos, cuando traducimos términos aislados sin contexto, observamos una visión sin sesgo, indicando ambas posibilidades. Además, nos informa de que la traducción cambia según el género. Este tipo de elecciones nos debería ofrecer la traducción con IA en todos los casos para liberarnos del sesgo.

Otra solución es el aumento de mujeres profesionales en al ámbito digital. Según el informe de la ONU, sólo el 12% de los investigadores de IA y el 6% de los desarrolladores de software son mujeres, lo que es un factor impulsor del comportamiento sexista de los asistentes virtuales.

Al final los programadores alimentan a la IA con datos que eligen. Por ello, resulta que los modelos solo son tan buenos como los datos que reciben. No es lo mismo, si los programadores son mayoritariamente hombres o mujeres, ya que también comparten su visión del mundo, y los sesgos que ello conlleva. Con una visión que tenga en cuenta una representación de todos los grupos, categorías y colectivos, podemos crear un marco más neutral en los datos con los que alimentamos la Inteligencia Artificial. Por ello, es de suma importancia que las empresas apuesten por modelos sin sesgo y que estén basados en un fuerte componente ético, no solo en referencia a la traducción asistida, sino como apuesta global para entrenar la IA.

Aura, un ejemplo de Inteligencia Artificial que demuestra el esfuerzo en materia de ética y sesgo

En la IA de Telefónica, Aura, se está poniendo mucha atención y esfuerzo para que sea una plataforma de Inteligencia Artificial inclusiva y diversa. El equipo trabaja constantemente para identificar los grandes retos a los que se enfrenta y lanza investigaciones periódicas. Así conoce como la industria los enfrenta, cómo se perciben por la sociedad en los diferentes países y los avances tecnológicos que pueden ayudar a conseguir una plataforma sin sesgos.

En esos retos se incluyen desde el tono de voz del asistente en cada una de las respuestas que ofrece, pasando por un entendimiento del lenguaje o un reconocimiento de voz equitativo entre sexos y edades, hasta el modelaje de los datos para obtener insights. Por ello, Aura es un ser artificial que no tiene género, como tampoco come, bebe o siente. Aura no transmite al cliente algo que no es, ni reproduce comportamientos de los humanos que sigan incidiendo en ese tipo de sesgos.

Desde la plataforma Aura se incide mucho para que todos los desarrolladores que construyan sobre Aura cumplan esos principios. Aunque no siempre es fácil. Por eso, se realizan auditorías periódicas que ayudan a corregir posibles desviaciones en ese tono de voz. Es importante insistir en una Inteligencia Artificial sin sesgos y basada en respetar la ética, para poder conseguir un futuro igualitario tanto en el lenguaje artificial como en conversaciones entre personas.