Estamos inmersos en una revolución tecnológica en la que la inteligencia artificial se encuentra en el centro de todo. Toda empresa que se precie del sector tecnológico tiene ya su propio modelo de IA. Y tanto empresas como organismos públicos y particulares emplean estos modelos en su día a día de mil maneras distintas. Sin embargo, estos requieren una elevada cantidad de procesado. O dicho de otro modo: hacen falta máquinas potentes, costosas y que consumen electricidad tanto durante la ejecución como en durante el entrenamiento. ¿Cómo se soluciona este problema? Apostando por modelos destilados de IA.

La destilación de modelos se conoce también como destilación de LLM, entrenamiento de LLM o por las expresiones inglesas knowledge distillation o model distillation. Estos conceptos nacieron en el ámbito del machine learning. Y, según define la Wikipedia, consiste en transferir conocimiento desde un modelo grande a uno más pequeño. Por modelo, en este caso, nos referimos a un modelo de IA –también bautizado como LLM o Large Language Model–, es decir, la base de conocimiento en la que se sustenta cualquier inteligencia artificial actual.

Entrenar correctamente una inteligencia artificial es imprescindible para que dé buenos resultados en el futuro. Precisamente, la explosión de modelos de IA en la que nos encontramos actualmente tiene su origen en nuevas estrategias para entrenar sus modelos por parte de empresas como OpenAI, Google, Microsoft, Meta o Anthropic. Gigantes como Google o Microsoft llevaban años desarrollando modelos de IA muy avanzados pero los entrenaban de una forma prácticamente artesanal. OpenAI, en cambio, decidió apostar por una combinación de métodos: entrenamiento previo masivo no supervisado, uso de transformers autoregresivos y aprendizaje posterior por refuerzo con interacción humana. ¿El problema? Los modelos surgidos con esta estrategia tienen un coste elevado en el uso de hardware, es decir, chips, servidores y centros de datos.

OpenAI y los modelos destilados de lA

Los modelos destilados de lA, como decíamos antes, son consecuencia de la necesidad de que los modelos sean eficientes. Es decir, la destilación de modelos pretende obtener más de un modelo de IA más pequeño, o estudiante, entrenándolo con un modelo mayor, o maestro. Es decir: se reutiliza ese modelo grande con el fin de que el modelo pequeño replique al mayor en todo lo que sea posible, pero siendo mucho más ligero. Dentro de sus limitaciones, eso sí. De esta forma, con menos recursos, es posible obtener un modelo de IA con un desempeño más próximo al modelo grande, pero a un menor coste.

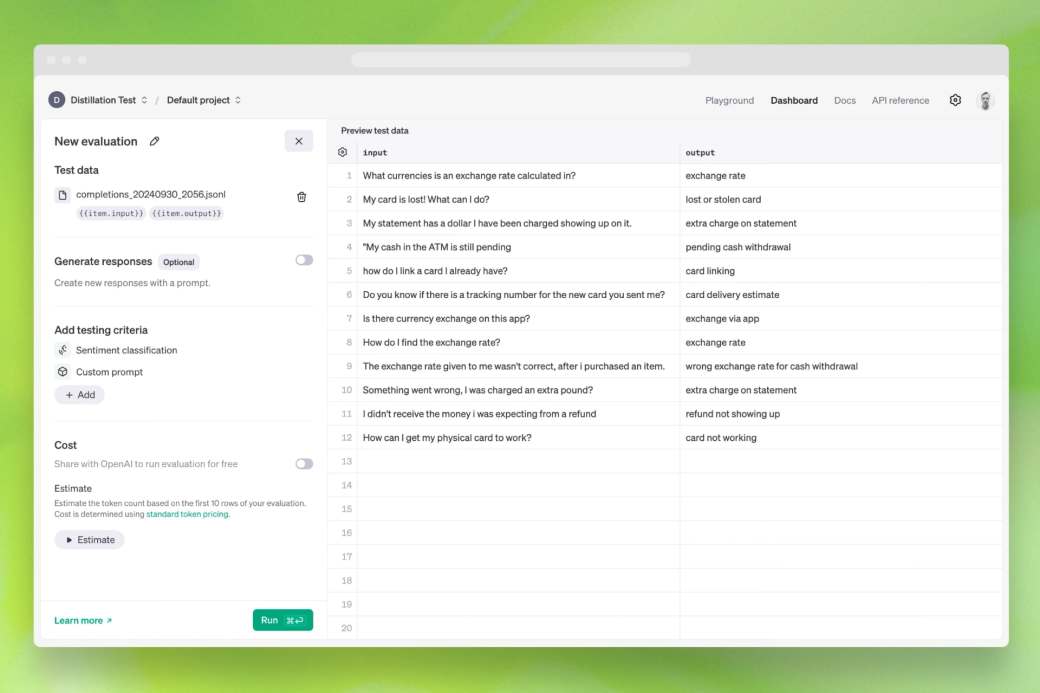

En relación a esto, el pasado mes de octubre de 2024, OpenAI anunció la inclusión de Model Distillation en su API. Una nueva función para desarrolladores que consistía, en esta ocasión, en utilizar los resultados de modelos de frontera como o1-preview y GPT-4o para ajustar y mejorar el rendimiento de modelos más eficientes como GPT-4o mini. La idea, como vimos antes, no es nueva. Es algo que ya se venía haciendo en el campo del machine learning. La novedad está en que OpenAI simplifica el proceso.

“Hasta ahora, la destilación ha sido un proceso de varios pasos y propenso a errores, que requería que los desarrolladores orquestaran manualmente múltiples operaciones a través de herramientas desconectadas, desde la generación de conjuntos de datos hasta el ajuste fino de modelos y la medición de mejoras de rendimiento.”

Ventajas e inconvenientes de los modelos destilados de IA

Destilar un modelo de IA en vez de utilizar un modelo de grandes dimensiones tiene múltiples ventajas. La principal es que podemos usar un modelo de IA pequeño, como es GPT-4o mini, pero con un rendimiento mayor. A su vez, esto reduce los parámetros a almacenar y desplegar. Es decir, que ocupa menos espacio. Y otra ventaja es que requiere menos capacidad de procesamiento.

Por último, usar modelos destilados de IA implica emplear menos hardware, o un hardware más reducido. De manera que también obtenemos eficiencia energética (menos consumo de electricidad). Lo que tiene implicaciones secundarias: desde reducir los costes operativos hasta poder ejecutar ese modelo de IA en dispositivos móviles o aparatos de domótica o Internet de las cosas.

Más rendimiento por menos. Menos espacio de almacenamiento. Más velocidad, incluso en equipos más modestos o no tan potentes. Eficiencia energética. Si todo son ventajas, ¿por qué no hemos visto o hablado hasta ahora de la destilación de modelos de inteligencia artificial? La principal razón es porque es fácil de decir, pero complejo de realizar.

En primer lugar, necesitas un modelo grande que haga de maestro del modelo pequeño. Esto ya es de por sí complicado, ya que entrenar un modelo LLM requiere esfuerzo, tiempo y recursos que no están al alcance de cualquiera. Y una vez contamos con ese modelo de IA, el entrenamiento por destilación implica ajustar parámetros, supervisar el proceso, aprender de los errores y asignar a la IA una serie de tareas específicas difíciles de diseñar.

Instalar modelos destilados en cualquier PC

Otra ventaja de destilar un modelo de IA es que, en el caso de los modelos de código abierto como Llama (Meta), Mixtral (Mistral) o DeepSeek, es posible instalar una versión más reducida en nuestros ordenadores. Pongamos de ejemplo DeepSeek, la inteligencia artificial china que hizo tambalear el valor de Nvidia en bolsa y el proyecto Stargate de OpenAI. Las críticas a esta IA no se hicieron esperar. Principalmente, que tenía prohibido hablar de ciertos temas espinosos en territorio chino. Pero al ser una IA de código abierto, cualquiera puede instalarla en un servidor u ordenador y ejecutarla en modo local. Con los parámetros que queramos. Sin censura. Algo que, por contra, no podemos hacer con los modelos de IA propietarios, como GPT, Claude o Gemini.

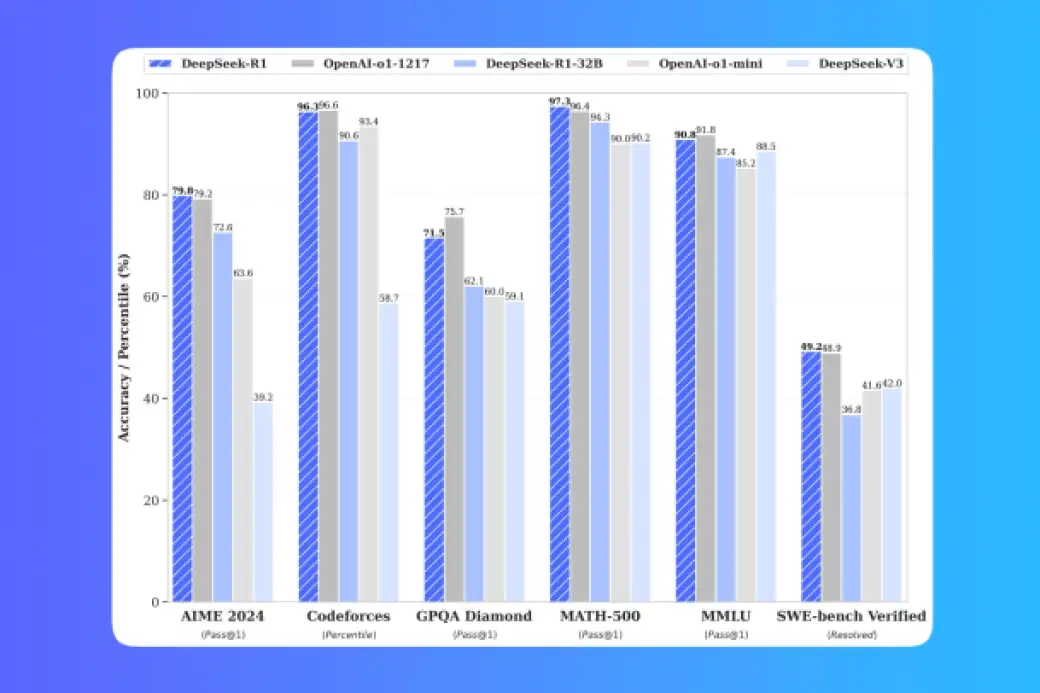

Siguiendo con el ejemplo de DeepSeek, varios desarrolladores corrieron a buscar una versión más pequeña. DeepSeek R1 tiene varios tamaños, según la cantidad de parámetros a procesar. Entre 1,5B y 671B. El modelo más pequeño, 1,5B, requiere 8GB de RAM. Pero los modelos de mayor tamaño implican el uso de GPU. Por ejemplo. DeepSeek R1 con entre 7B y 8B, necesita una GPU con un mínimo de 8GB de VRAM. El modelo medio, entre 14B y 23B, requiere una GPU con entre 12 y 24 GB de VRAM. Y los modelos más complejos, entre 70B y 671B, necesitan GPU de 48GB de VRAM y varias tarjetas gráficas simultáneas. Por ejemplo, 20 Nvidia RTX 3090 o 10 Nvidia RTX A6000.

Así que, como decía, desarrolladores entusiastas utilizaron centenares de miles de ejemplos de datos de razonamiento generados por DeepSeek R1 para ajustar modelos de IA más pequeños y de código abierto, como Qwen (Alibaba) o Llama (Meta). En la plataforma HuggingFace podemos encontrar estos modelos destilados con una larga explicación sobre el proceso de destilación y los resultados de las principales pruebas para modelos de IA en áreas de conocimiento como inglés, programación o matemáticas.

Una tendencia para democratizar la IA

El ejemplo de DeepSeek es una muestra reciente de que el destilado de modelos de IA puede dar pie a grandes avances en el uso y desarrollo de inteligencia artificial. Bien combinando varios modelos LLM de código abierto, para que aprendan unos de otros. O entrenando los modelos pequeños de una misma compañía, como GPT, Gemini o Claude, a través de sus versiones superiores. Pero es algo en lo que ya se estaba trabajando con anterioridad. El caso de OpenAI en su API solo lo ha puesto sobre la mesa. O el de Microsoft en su plataforma Azure.

Desde finales de 2024, Microsoft incorpora la destilación de modelos de IA como servicio en su infraestructura en la nube. De momento, con Llama (Meta) como modelo maestro y estudiante. El modelo maestro es Llama 3.1 405B. Y el modelo estudiante, Llama 3.1 8B. En el futuro, también incorporará su propio modelo Phi 3 y 3.5.

Otros ejemplos de destilación de modelos de IA es el de BERT (Google) y sus versiones destiladas DistilBERT (2019) o TinyBERT (2019). En el ámbito de la investigación científica o en el desarrollo de tecnologías como la visión por computadora o las redes neuronales profundas, la destilación permite y permitirá ejecutar modelos de inteligencia artificial en dispositivos más modestos y de menos prestaciones. O dicho de otra manera, los modelos destilados de IA permiten introducir la inteligencia artificial en cualquier rincón con el menor coste y el máximo de rendimiento posibles.